CS229 讲义(备份版)

第一章

监督学习(Supervised learning)

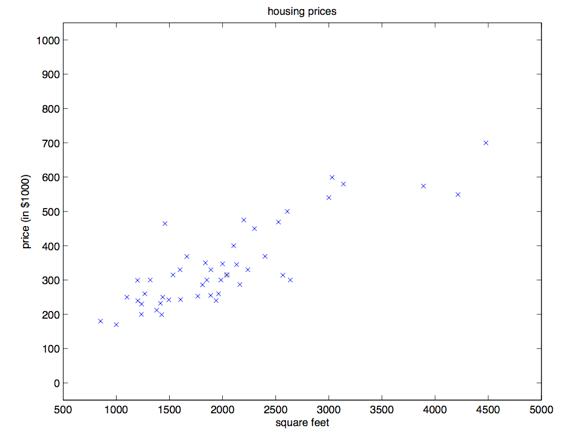

咱们先来聊几个使用监督学习来解决问题的实例。假如咱们有一个数据集,里面的数据是俄勒冈州波特兰市的 $47$ 套房屋的面积和价格:

| 居住面积(平方英尺) | 价格(千美元) |

|---|---|

| $2104$ | $400$ |

| $1600$ | $330$ |

| $2400$ | $369$ |

| $1416$ | $232$ |

| $3000$ | $540$ |

| $\vdots$ | $\vdots$ |

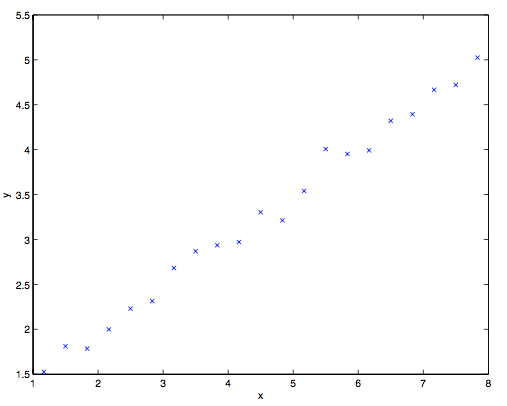

用这些数据来投个图:

有了这样的数据,我们怎样才能学会预测波特兰其他房屋的价格,以及它们的居住面积?

这里要先规范一下符号和含义,这些符号以后还要用到,咱们假设 $x^{(i)}$ 表示 “输入的” 变量值(在这个例子中就是房屋面积),也可以叫做输入特征;然后咱们用 $y^{(i)}$ 来表示“输出值”,或者称之为目标变量,这个例子里面就是房屋价格。这样的一对 $(x^{(i)},y^{(i)})$就称为一组训练样本,然后咱们用来让机器来学习的数据集,就是——一个长度为 $m$ 的训练样本的列表${(x^{(i)},y^{(i)}); i = 1,\dots ,m}$——也叫做一个训练集。另外一定注意,这里的上标$(i)$只是作为训练集的索引记号,和数学乘方没有任何关系,千万别误解了。另外我们还会用大写的$X$来表示 输入值的空间,大写的$Y$表示输出值的空间。在本节的这个例子中,输入输出的空间都是实数域,所以 $X = Y = R$。

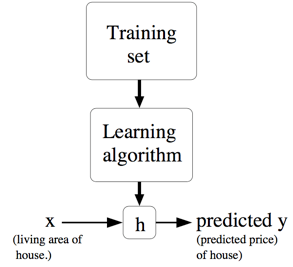

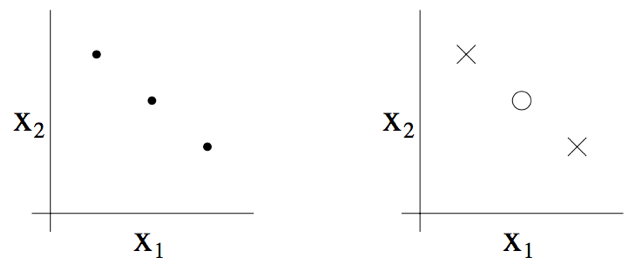

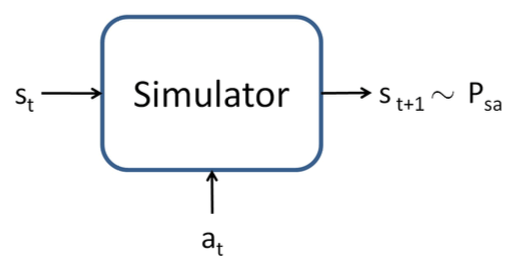

然后再用更加规范的方式来描述一下监督学习问题,我们的目标是,给定一个训练集,来让机器学习一个函数 $h: X → Y$,让 $h(x)$ 是一个与对应的真实 $y$ 值比较接近的评估值。由于一些历史上的原因,这个函数 $h$ 就被叫做假设(hypothesis)。用一个图来表示的话,这个过程大概就是下面这样:

如果我们要预测的目标变量是连续的,比如在咱们这个房屋价格-面积的案例中,这种学习问题就被称为回归问题。 如果$y$只能取一小部分的离散的值(比如给定房屋面积,咱们要来确定这个房子是一个住宅还是公寓),这样的问题就叫做分类问题。

第一部分 线性回归

为了让我们的房屋案例更有意思,咱们稍微对数据集进行一下补充,增加上每一个房屋的卧室数目:

| 居住面积(平方英尺) | 卧室数目 | 价格(千美元) |

|---|---|---|

| $2104$ | $3$ | $400$ |

| $1600$ | $3$ | $330$ |

| $2400$ | $3$ | $369$ |

| $1416$ | $2$ | $232$ |

| $3000$ | $4$ | $540$ |

| $\vdots$ | $\vdots$ | $\vdots$ |

现在,输入特征 $x$ 就是在 $R^2$ 范围取值的一个二维向量了。例如 $x_1^{(i)}$ 就是训练集中第 $i$ 个房屋的面积,而 $x_2^{(i)}$ 就是训练集中第 $i$ 个房屋的卧室数目。(通常来说,设计一个学习算法的时候,选择哪些输入特征都取决于你,所以如果你不在波特兰收集房屋信息数据,你也完全可以选择包含其他的特征,例如房屋是否有壁炉,卫生间的数量啊等等。关于特征筛选的内容会在后面的章节进行更详细的介绍,不过目前来说就暂时先用给定的这两个特征了。)

要进行这个监督学习,咱们必须得确定好如何在计算机里面对这个函数/假设 $h$ 进行表示。咱们现在刚刚开始,就来个简单点的,咱们把 $y$ 假设为一个以 $x$ 为变量的线性函数:

$$

h_\theta (x) = \theta_0 + \theta_1 \times x_1 + \theta_2 \times x_2

$$

这里的$\theta_i$是参数(也可以叫做权重),是从 $x$ 到 $y$ 的线性函数映射的空间参数。在不至于引起混淆的情况下,咱们可以把$h_\theta(x)$ 里面的 $\theta$ 省略掉,就简写成 $h(x)$。另外为了简化公式,咱们还设 $x_0 = 1$(这个为 截距项 intercept term)。这样简化之后就有了:

$$

h(x) = \sum^n_{i=0} \theta_i x_i = \theta^T x

$$

等式最右边的 $\theta$ 和 $x$ 都是向量,等式中的 $n$ 是输入变量的个数(不包括$x_0$)。

现在,给定了一个训练集,咱们怎么来挑选/学习参数 $\theta$ 呢?一个看上去比较合理的方法就是让 $h(x)$ 尽量逼近 $y$,至少对咱已有的训练样本能适用。用公式的方式来表示的话,就要定义一个函数,来衡量对于每个不同的 $\theta$ 值,$h(x^{(i)})$ 与对应的 $y^{(i)}$ 的距离。这样用如下的方式定义了一个 成本函数 (cost function):

$$

J(\theta) = \frac 12 \sum^m_{i=1}(h_\theta(x^{(i)})-y^{(i)})^2

$$

如果之前你接触过线性回归,你会发现这个函数和常规最小二乘法 拟合模型中的最小二乘法成本函数非常相似。不管之前接触过没有,咱们都接着往下进行,以后就会发现这是一个更广泛的算法家族中的一个特例。

1 最小均方算法(LMS algorithm)

我们希望选择一个能让 $J(\theta)$ 最小的 $\theta$ 值。怎么做呢,咱们先用一个搜索的算法,从某一个对 $\theta$ 的“初始猜测值”,然后对 $\theta$ 值不断进行调整,来让 $J(\theta)$ 逐渐变小,最好是直到我们能够达到一个使 $J(\theta)$ 最小的 $\theta$。具体来说,咱们可以考虑使用梯度下降法(gradient descent algorithm),这个方法就是从某一个 $\theta$ 的初始值开始,然后逐渐重复更新:$^1$

$$

\theta_j := \theta_j - \alpha \frac \partial {\partial\theta_j}J(\theta)

$$

(上面的这个更新要同时对应从 $0$ 到 $n$ 的所有$j$ 值进行。)这里的 $\alpha$ 也称为学习速率。这个算法是很自然的,逐步重复朝向 $J$ 降低最快的方向移动。

1 本文中 $:= $ 表示的是计算机程序中的一种赋值操作,是把等号右边的计算结果赋值给左边的变量,$a := b$ 就表示用 $b$ 的值覆盖原有的$a$值。要注意区分,如果写的是 $a == b$ 则表示的是判断二者相等的关系。(译者注:在 Python 中,单个等号 $=$ 就是赋值,两个等号 $==$ 表示相等关系的判断。)

要实现这个算法,咱们需要解决等号右边的导数项。首先来解决只有一组训练样本 $(x, y)$ 的情况,这样就可以忽略掉等号右边对 $J$ 的求和项目了。公式就简化下面这样:

$$

\begin{aligned}

\frac \partial {\partial\theta_j}J(\theta) & = \frac \partial {\partial\theta_j} \frac 12(h_\theta(x)-y)^2\

& = 2 \cdot\frac 12(h_\theta(x)-y)\cdot \frac \partial {\partial\theta_j} (h_\theta(x)-y) \

& = (h_\theta(x)-y)\cdot \frac \partial {\partial\theta_j}(\sum^n_{i=0} \theta_ix_i-y) \

& = (h_\theta(x)-y) x_j

\end{aligned}

$$

对单个训练样本,更新规则如下所示:

$$

\theta_j := \theta_j + \alpha (y^{(i)}-h_\theta (x^{(i)}))x_j^{(i)}

$$

这个规则也叫 LMS 更新规则 (LMS 是 “least mean squares” 的缩写,意思是最小均方),也被称为 Widrow-Hoff 学习规则。这个规则有几个看上去就很自然直观的特性。例如,更新的大小与$(y^{(i)} − h_\theta(x^{(i)}))$成正比;另外,当我们遇到训练样本的预测值与 $y^{(i)}$ 的真实值非常接近的情况下,就会发现基本没必要再对参数进行修改了;与此相反的情况是,如果我们的预测值 $h_\theta(x^{(i)})$ 与 $y^{(i)}$ 的真实值有很大的误差(比如距离特别远),那就需要对参数进行更大地调整。

当只有一个训练样本的时候,我们推导出了 LMS 规则。当一个训练集有超过一个训练样本的时候,有两种对这个规则的修改方法。第一种就是下面这个算法:

$

\begin{aligned}

&\qquad 重复直到收敛 { \

&\qquad\qquad\theta_j := \theta_j + \alpha \sum^m_{i=1}(y^{(i)}-h_\theta (x^{(i)}))x_j^{(i)}\quad(对每个j) \

&\qquad}

\end{aligned}

$

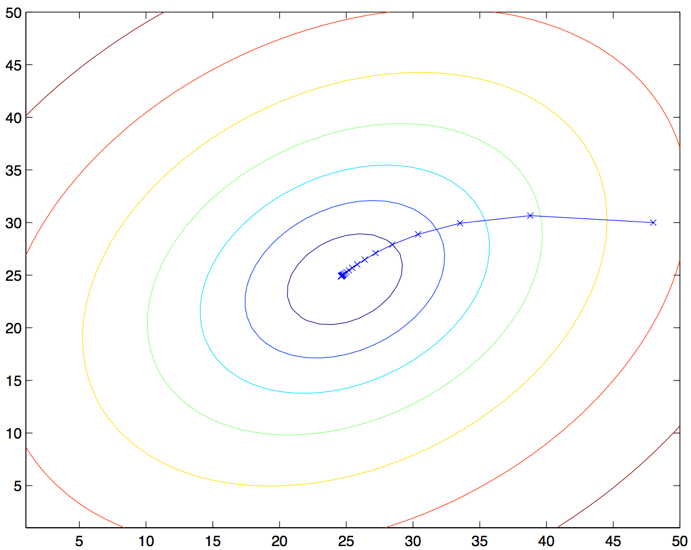

读者很容易能证明,在上面这个更新规则中求和项的值就是$\frac {\partial J(\theta)}{\partial \theta_j}$ (这是因为对 $J$ 的原始定义)。所以这个更新规则实际上就是对原始的成本函数 $J $进行简单的梯度下降。这一方法在每一个步长内检查所有整个训练集中的所有样本,也叫做批量梯度下降法(batch gradient descent)。这里要注意,因为梯度下降法容易被局部最小值影响,而我们要解决的这个线性回归的优化问题只能有一个全局的而不是局部的最优解;因此,梯度下降法应该总是收敛到全局最小值(假设学习速率 $\alpha$ 不设置的过大)。$J$ 很明确是一个凸二次函数。下面是一个样例,其中对一个二次函数使用了梯度下降法来找到最小值。

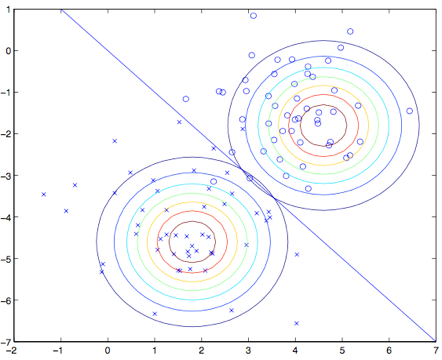

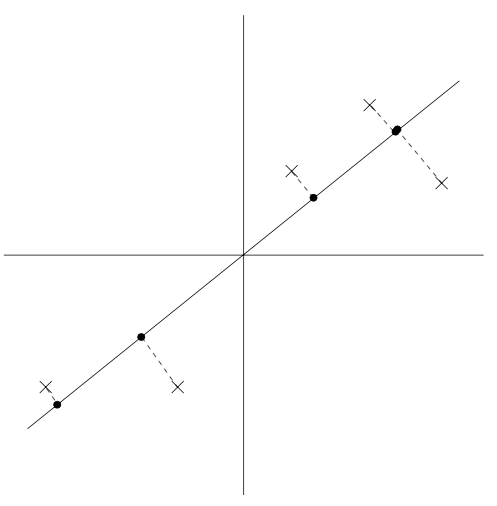

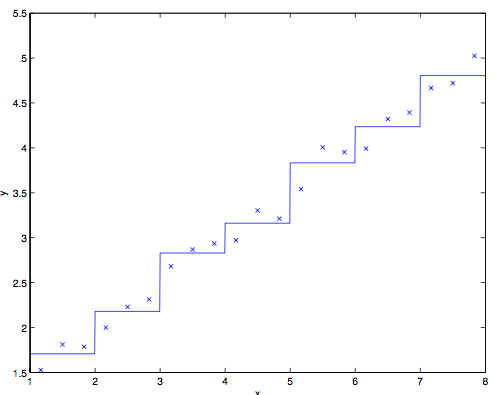

上图的椭圆就是一个二次函数的轮廓图。图中还有梯度下降法生成的规矩,初始点位置在$(48,30)$。图中的画的 $x$ (用直线连接起来了)标记了梯度下降法所经过的 $\theta$ 的可用值。

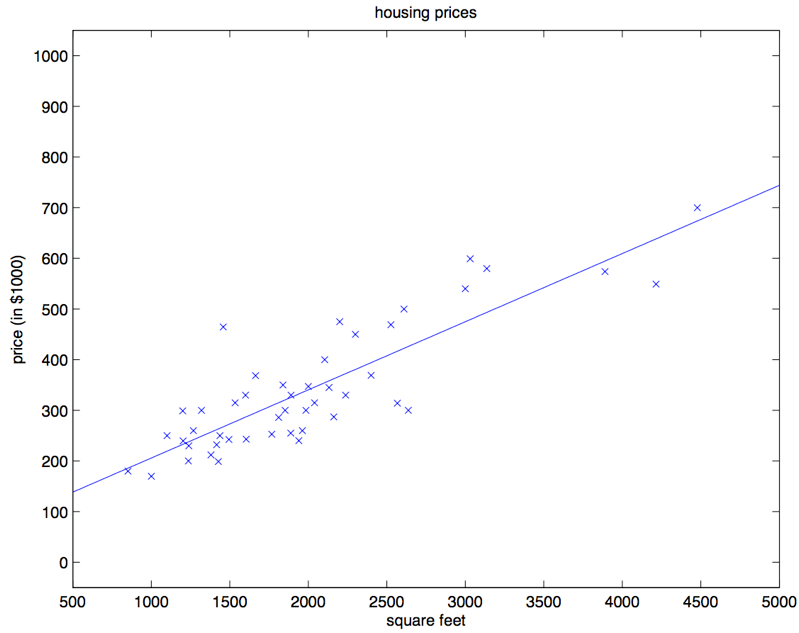

对咱们之前的房屋数据集进行批量梯度下降来拟合 $\theta$ ,把房屋价格当作房屋面积的函数来进行预测,我们得到的结果是 $\theta_0 = 71.27, \theta_1 = 0.1345$。如果把 $h_{\theta}(x)$ 作为一个定义域在 $x$ 上的函数来投影,同时也投上训练集中的已有数据点,会得到下面这幅图:

如果在数据集中添加上卧室数目作为输入特征,那么得到的结果就是 $\theta_0 = 89.60, \theta_1 = 0.1392, \theta_2 = −8.738$

这个结果就是用批量梯度下降法来获得的。此外还有另外一种方法能够替代批量梯度下降法,这种方法效果也不错。如下所示:

$

\begin{aligned}

&\qquad循环:{ \

&\qquad\qquad i从1到m,{ \

&\qquad\qquad\qquad\theta_j := \theta_j +\alpha(y^{(i)}-h_{\theta}(x^{(i)}))x_j^{(i)} \qquad(对每个 j) \

&\qquad\qquad} \

&\qquad}

\end{aligned}

$

在这个算法里,我们对整个训练集进行了循环遍历,每次遇到一个训练样本,根据每个单一训练样本的误差梯度来对参数进行更新。这个算法叫做随机梯度下降法(stochastic gradient descent),或者叫增量梯度下降法(incremental gradient descent)。批量梯度下降法要在运行第一步之前先对整个训练集进行扫描遍历,当训练集的规模 $m$ 变得很大的时候,引起的性能开销就很不划算了;随机梯度下降法就没有这个问题,而是可以立即开始,对查询到的每个样本都进行运算。通常情况下,随机梯度下降法查找到足够接近最低值的 $\theta$ 的速度要比批量梯度下降法更快一些。(也要注意,也有可能会一直无法收敛(converge)到最小值,这时候 $\theta$ 会一直在 $J(\theta)$ 最小值附近震荡;不过通常情况下在最小值附近的这些值大多数其实也足够逼近了,足以满足咱们的精度要求,所以也可以用。$^2$)由于这些原因,特别是在训练集很大的情况下,随机梯度下降往往比批量梯度下降更受青睐。

2 当然更常见的情况通常是我们事先对数据集已经有了描述,并且有了一个确定的学习速率$\alpha$,然后来运行随机梯度下降,同时逐渐让学习速率 $\alpha$ 随着算法的运行而逐渐趋于 $0$,这样也能保证我们最后得到的参数会收敛到最小值,而不是在最小值范围进行震荡。(译者注:由于以上种种原因,通常更推荐使用的都是随机梯度下降法,而不是批量梯度下降法,尤其是在训练用的数据集规模大的时候。)

2 法方程(The normal equations)

上文中的梯度下降法是一种找出 $J$ 最小值的办法。然后咱们聊一聊另一种实现方法,这种方法寻找起来简单明了,而且不需要使用迭代算法。这种方法就是,我们直接利用找对应导数为 $0$ 位置的 $\theta_j$,这样就能找到 $J$ 的最小值了。我们想实现这个目的,还不想写一大堆代数公式或者好几页的矩阵积分,所以就要介绍一些做矩阵积分的记号。

2.1 矩阵导数(Matrix derivatives)

假如有一个函数 $f: R^{m\times n} → R$ 从 $m\times n$ 大小的矩阵映射到实数域,那么就可以定义当矩阵为 $A$ 的时候有导函数 $f$ 如下所示:

$$

\nabla_A f(A)=\begin{bmatrix} \frac {\partial f}{\partial A_{11}} & \dots & \frac {\partial f}{\partial A_{1n}} \ \vdots & \ddots & \vdots \ \frac {\partial f}{\partial A_{m1}} & \dots & \frac {\partial f}{\partial A_{mn}} \ \end{bmatrix}

$$

因此,这个梯度 $\nabla_A f(A)$本身也是一个 $m\times n$ 的矩阵,其中的第 $(i,j)$ 个元素是 $\frac {\partial f}{\partial A_{ij}} $ 。

假如 $ A =\begin{bmatrix} A_{11} & A_{12} \ A_{21} & A_{22} \ \end{bmatrix} $ 是一个 $2\times 2$ 矩阵,然后给定的函数 $f:R^{2\times 2} → R$ 为:

$$

f(A) = \frac 32A_{11}+5A^2_{12}+A_{21}A_{22}

$$

这里面的 $A_{ij}$ 表示的意思是矩阵 $A$ 的第 $(i,j)$ 个元素。然后就有了梯度:

$$

\nabla A f(A) =\begin{bmatrix} \frac 32 & 10A{12} \ A_{22} & A_{21} \ \end{bmatrix}

$$

然后咱们还要引入 $trace$ 求迹运算,简写为 $“tr”$。对于一个给定的 $n\times n$ 方形矩阵 $A$,它的迹定义为对角项和:

$$

trA = \sum^n_{i=1} A_{ii}

$$

假如 $a$ 是一个实数,实际上 $a$ 就可以看做是一个 $1\times 1$ 的矩阵,那么就有 $a$ 的迹 $tr a = a$。(如果你之前没有见到过这个“运算记号”,就可以把 $A$ 的迹看成是 $tr(A)$,或者理解成为一个对矩阵 $A$ 进行操作的 $trace$ 函数。不过通常情况都是写成不带括号的形式更多一些。)

如果有两个矩阵 $A$ 和$B$,能够满足 $AB$ 为方阵,$trace$ 求迹运算就有一个特殊的性质: $trAB = trBA$ (自己想办法证明)。在此基础上进行推论,就能得到类似下面这样的等式关系:

$$

trABC=trCAB=trBCA \

trABCD=trDABC=trCDAB=trBCDA

$$

下面这些和求迹运算相关的等量关系也很容易证明。其中 $A$ 和 $B$ 都是方形矩阵,$a$ 是一个实数:

$$

trA=trA^T \

tr(A+B)=trA+trB \

tr a A=a trA

$$

接下来咱们就来在不进行证明的情况下提出一些矩阵导数(其中的一些直到本节末尾才用得上)。另外要注意等式$(4)$中的$A$ 必须是非奇异方阵(non-singular square matrices),而 $|A|$ 表示的是矩阵 $A$ 的行列式。那么我们就有下面这些等量关系:

$$

\begin{aligned}

\nabla_A tr AB & = B^T & \text{(1)}\

\nabla_{A^T} f(A) & = (\nabla_{A} f(A))^T &\text{(2)}\

\nabla_A tr ABA^TC& = CAB+C^TAB^T &\text{(3)}\

\nabla_A|A| & = |A|(A^{-1})^T &\text{(4)}\

\end{aligned}

$$

为了让咱们的矩阵运算记号更加具体,咱们就详细解释一下这些等式中的第一个。假如我们有一个确定的矩阵 $B \in R^{n\times m}$(注意顺序,是$n\times m$,这里的意思也就是 $B$ 的元素都是实数,$B$ 的形状是 $n\times m$ 的一个矩阵),那么接下来就可以定义一个函数$ f: R^{m\times n} → R$ ,对应这里的就是 $f(A) = trAB$。这里要注意,这个矩阵是有意义的,因为如果 $A \in R^{m\times n} $,那么 $AB$ 就是一个方阵,是方阵就可以应用 $trace$ 求迹运算;因此,实际上 $f$ 映射的是从 $R^{m\times n} $ 到实数域 $R$。这样接下来就可以使用矩阵导数来找到 $\nabla_Af(A)$ ,这个导函数本身也是一个 $m \times n $的矩阵。上面的等式$(1)$ 表明了这个导数矩阵的第 $(i,j)$个元素等同于 $B^T$ ($B$的转置)的第 $(i,j)$ 个元素,或者更直接表示成 $B_{ji}$。

上面等式$(1-3)$ 都很简单,证明就都留给读者做练习了。等式$(4)$需要用逆矩阵的伴随矩阵来推导出。$^3$

3 假如咱们定义一个矩阵 $A’$,它的第 $(i,j)$ 个元素是$ (−1)^{i+j}$ 与矩阵 $A $移除 第 $i$ 行 和 第 $j$ 列 之后的行列式的乘积,则可以证明有$A^{−1} = (A’)^T /|A|$。(你可以检查一下,比如在 $A$ 是一个 $2\times 2$ 矩阵的情况下看看 $A^{-1}$ 是什么样的,然后以此类推。如果你想看看对于这一类结果的证明,可以参考一本中级或者高级的线性代数教材,比如Charles Curtis, 1991, Linear Algebra, Springer。)这也就意味着 $A’ = |A|(A^{−1})^T $。此外,一个矩阵 $A$ 的行列式也可以写成 $|A| = \sum_j A_{ij}A’{ij}$ 。因为 $(A’){ij}$ 不依赖 $A_{ij}$ (通过定义也能看出来),这也就意味着$(\frac \partial {\partial A_{ij}})|A| = A’_{ij} $,综合起来也就得到上面的这个结果了。

2.2 最小二乘法回顾(Least squares revisited)

通过刚才的内容,咱们大概掌握了矩阵导数这一工具,接下来咱们就继续用逼近模型(closed-form)来找到能让 $J(\theta)$ 最小的 $\theta$ 值。首先咱们把 $J$ 用矩阵-向量的记号来重新表述。

给定一个训练集,把设计矩阵(design matrix) $x$ 设置为一个 $m\times n$ 矩阵(实际上,如果考虑到截距项,也就是 $\theta_0$ 那一项,就应该是 $m\times (n+1)$ 矩阵),这个矩阵里面包含了训练样本的输入值作为每一行:

$$

X =\begin{bmatrix}

-(x^{(1)}) ^T-\

-(x^{(2)}) ^T-\

\vdots \

-(x^{(m)}) ^T-\

\end{bmatrix}

$$

然后,咱们设 $\vec{y}$ 是一个 $m$ 维向量(m-dimensional vector),其中包含了训练集中的所有目标值:

$$

y =\begin{bmatrix}

y^{(1)}\

y^{(2)}\

\vdots \

y^{(m)}\

\end{bmatrix}

$$

因为 $h_\theta (x^{(i)}) = (x^{(i)})^T\theta $译者注:这个怎么推出来的我目前还没尝试,目测不难,所以可以证明存在下面这种等量关系:

$$

\begin{aligned}

X\theta - \vec{y} &=

\begin{bmatrix}

(x^{(1)})^T\theta \

\vdots \

(x^{(m)})^T\theta\

\end{bmatrix} -

\begin{bmatrix}

y^{(1)}\

\vdots \

y^{(m)}\

\end{bmatrix}\

& =

\begin{bmatrix}

h_\theta (x^{1}) -y^{(1)}\

\vdots \

h_\theta (x^{m})-y^{(m)}\

\end{bmatrix}\

\end{aligned}

$$

对于向量 $\vec{z}$ ,则有 $z^T z = \sum_i z_i^2$ ,因此利用这个性质,可以推出:

$$

\begin{aligned}

\frac 12(X\theta - \vec{y})^T (X\theta - \vec{y}) &=\frac 12 \sum^m_{i=1}(h_\theta (x^{(i)})-y^{(i)})^2\

&= J(\theta)

\end{aligned}

$$

最后,要让 $J$ 的值最小,就要找到函数对于$\theta$导数。结合等式$(2)$和等式$(3)$,就能得到下面这个等式$(5)$:

$$

\nabla_{A^T} trABA^TC =B^TA^TC^T+BA^TC \qquad \text{(5)}

$$

因此就有:

$$

\begin{aligned}

\nabla_\theta J(\theta) &= \nabla_\theta \frac 12 (X\theta - \vec{y})^T (X\theta - \vec{y}) \

&= \frac 12 \nabla_\theta (\theta ^TX^TX\theta -\theta^T X^T \vec{y} - \vec{y} ^TX\theta +\vec{y}^T \vec{y})\

&= \frac 12 \nabla_\theta tr(\theta ^TX^TX\theta -\theta^T X^T \vec{y} - \vec{y} ^TX\theta +\vec{y}^T \vec{y})\

&= \frac 12 \nabla_\theta (tr \theta ^TX^TX\theta - 2tr\vec{y} ^T X\theta)\

&= \frac 12 (X^TX\theta+X^TX\theta-2X^T\vec{y}) \

&= X^TX\theta-X^T\vec{y}\

\end{aligned}

$$

在第三步,我们用到了一个定理,也就是一个实数的迹就是这个实数本身;第四步用到了 $trA = trA^T$ 这个定理;第五步用到了等式$(5)$,其中 $A^T =\theta, B=B^T =X^TX, C=I$,还用到了等式 $(1)$。要让 $J$ 取得最小值,就设导数为 $0$ ,然后就得到了下面的法线方程(normal equations):

$$

X^TX\theta =X^T\vec{y}

$$

所以让 $J(\theta)$ 取值最小的 $\theta$ 就是

$$

\theta = (X^TX)^{-1}X^T\vec{y}

$$

3 概率解释(Probabilistic interpretation)

在面对回归问题的时候,可能有这样一些疑问,就是为什么选择线性回归,尤其是为什么选择最小二乘法作为成本函数 $J$ ?在本节里,我们会给出一系列的概率基本假设,基于这些假设,就可以推出最小二乘法回归是一种非常自然的算法。

首先咱们假设目标变量和输入值存在下面这种等量关系:

$$

y^{(i)}=\theta^T x^{(i)}+ \epsilon ^{(i)}

$$

上式中 $ \epsilon ^{(i)}$ 是误差项,用于存放由于建模所忽略的变量导致的效果 (比如可能某些特征对于房价的影响很明显,但我们做回归的时候忽略掉了)或者随机的噪音信息(random noise)。进一步假设 $ \epsilon ^{(i)}$ 是独立同分布的 (IID ,independently and identically distributed) ,服从高斯分布(Gaussian distribution ,也叫正态分布 Normal distribution),其平均值为 $0$,方差(variance)为 $\sigma ^2$。这样就可以把这个假设写成 $ \epsilon ^{(i)} ∼ N (0, \sigma ^2)$ 。然后 $ \epsilon ^{(i)} $ 的密度函数就是:

$$

p(\epsilon ^{(i)} )= \frac 1{\sqrt{2\pi}\sigma} exp (- \frac {(\epsilon ^{(i)} )^2}{2\sigma^2})

$$

这意味着存在下面的等量关系:

$$

p(y ^{(i)} |x^{(i)}; \theta)= \frac 1{\sqrt{2\pi}\sigma} exp (- \frac {(y^{(i)} -\theta^T x ^{(i)} )^2}{2\sigma^2})

$$

这里的记号 $“p(y ^{(i)} |x^{(i)}; \theta)”$ 表示的是这是一个对于给定 $x^{(i)}$ 时 $y^{(i)}$ 的分布,用$\theta$ 代表该分布的参数。 注意这里不能用 $\theta(“p(y ^{(i)} |x^{(i)},\theta)”)$来当做条件,因为 $\theta$ 并不是一个随机变量。这个 $y^{(i)}$ 的分布还可以写成$y^{(i)} | x^{(i)}; \theta ∼ N (\theta ^T x^{(i)}, \sigma^2)$。

给定一个设计矩阵(design matrix)$X$,其包含了所有的$x^{(i)}$,然后再给定 $\theta$,那么 $y^{(i)}$ 的分布是什么?数据的概率以$p (\vec{y}|X;\theta )$ 的形式给出。在$\theta$取某个固定值的情况下,这个等式通常可以看做是一个 $\vec{y}$ 的函数(也可以看成是 $X$ 的函数)。当我们要把它当做 $\theta$ 的函数的时候,就称它为 似然函数(likelihood function)

$$

L(\theta) =L(\theta;X,\vec{y})=p(\vec{y}|X;\theta)

$$

结合之前对 $\epsilon^{(i)}$ 的独立性假设 (这里对$y^{(i)}$ 以及给定的 $x^{(i)}$ 也都做同样假设),就可以把上面这个等式改写成下面的形式:

$$

\begin{aligned}

L(\theta) &=\prod ^m _{i=1}p(y^{(i)}|x^{(i)};\theta)\

&=\prod ^m _{i=1} \frac 1{\sqrt{2\pi}\sigma} exp(- \frac {(y^{(i)}-\theta^T x^{(i)})^2}{2\sigma^2})\

\end{aligned}

$$

现在,给定了$y^{(i)}$ 和 $x^{(i)}$之间关系的概率模型了,用什么方法来选择咱们对参数 $\theta$ 的最佳猜测呢?最大似然法(maximum likelihood)告诉我们要选择能让数据的似然函数尽可能大的 $\theta$。也就是说,咱们要找的 $\theta$ 能够让函数 $L(\theta)$ 取到最大值。

除了找到 $L(\theta)$ 最大值,我们还以对任何严格递增的 $L(\theta)$ 的函数求最大值。如果我们不直接使用 $L(\theta)$,而是使用对数函数,来找对数似然函数 $l(\theta)$ 的最大值,那这样对于求导来说就简单了一些:

$$

\begin{aligned}

l(\theta) &=\log L(\theta)\

&=\log \prod ^m _{i=1} \frac 1{\sqrt{2\pi}\sigma} exp(- \frac {(y^{(i)}-\theta^T x^{(i)})^2}{2\sigma^2})\

&= \sum ^m {i=1}log \frac 1{\sqrt{2\pi}\sigma} exp(- \frac {(y^{(i)}-\theta^T x^{(i)})^2}{2\sigma^2})\

&= m \log \frac 1{\sqrt{2\pi}\sigma}- \frac 1{\sigma^2}\cdot \frac 12 \sum^m{i=1} (y^{(i)}-\theta^Tx^{(i)})^2\

\end{aligned}

$$

因此,对 $l(\theta)$ 取得最大值也就意味着下面这个子式取到最小值:

$$

\frac 12 \sum^m _{i=1} (y^{(i)}-\theta^Tx^{(i)})^2

$$

到这里我们能发现这个子式实际上就是 $J(\theta)$,也就是最原始的最小二乘成本函数(least-squares cost function)。

总结一下也就是:在对数据进行概率假设的基础上,最小二乘回归得到的 $\theta$ 和最大似然法估计的 $\theta$ 是一致的。所以这是一系列的假设,其前提是认为最小二乘回归(least-squares regression)能够被判定为一种非常自然的方法,这种方法正好就进行了最大似然估计(maximum likelihood estimation)。(要注意,对于验证最小二乘法是否为一个良好并且合理的过程来说,这些概率假设并不是必须的,此外可能(也确实)有其他的自然假设能够用来评判最小二乘方法。)

另外还要注意,在刚才的讨论中,我们最终对 $\theta$ 的选择并不依赖 $\sigma^2$,而且也确实在不知道 $\sigma^2$ 的情况下就已经找到了结果。稍后我们还要对这个情况加以利用,到时候我们会讨论指数族以及广义线性模型。

4 局部加权线性回归(Locally weighted linear regression)

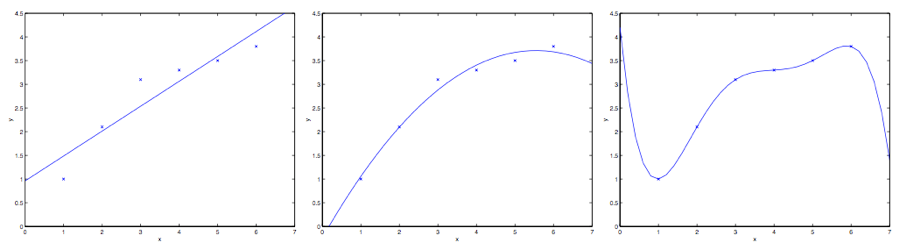

假如问题还是根据从实数域内取值的 $x\in R$ 来预测 $y$ 。左下角的图显示了使用 $y = \theta_0 + \theta_1x$ 来对一个数据集进行拟合。我们明显能看出来这个数据的趋势并不是一条严格的直线,所以用直线进行的拟合就不是好的方法。

那么这次不用直线,而增加一个二次项,用$y = \theta_0 + \theta_1x +\theta_2x^2$ 来拟合。(看中间的图) 很明显,我们对特征补充得越多,效果就越好。不过,增加太多特征也会造成危险的:最右边的图就是使用了五次多项式 $y = \sum^5_{j=0} \theta_jx^j$ 来进行拟合。看图就能发现,虽然这个拟合曲线完美地通过了所有当前数据集中的数据,但我们明显不能认为这个曲线是一个合适的预测工具,比如针对不同的居住面积 $x$ 来预测房屋价格 $y$。先不说这些特殊名词的正规定义,咱们就简单说,最左边的图像就是一个欠拟合(under fitting) 的例子,比如明显能看出拟合的模型漏掉了数据集中的结构信息;而最右边的图像就是一个过拟合(over fitting) 的例子。(在本课程的后续部分中,当我们讨论到关于学习理论的时候,会给出这些概念的标准定义,也会给出拟合程度对于一个猜测的好坏检验的意义。)

正如前文谈到的,也正如上面这个例子展示的,一个学习算法要保证能良好运行,特征的选择是非常重要的。(等到我们讲模型选择的时候,还会看到一些算法能够自动来选择一个良好的特征集。)在本节,咱们就简要地讲一下局部加权线性回归(locally weighted linear regression ,缩写为LWR),这个方法是假设有足够多的训练数据,对不太重要的特征进行一些筛选。这部分内容会比较简略,因为在作业中要求学生自己去探索一下LWR 算法的各种性质了。

在原始版本的线性回归算法中,要对一个查询点 $x$ 进行预测,比如要衡量$h(x)$,要经过下面的步骤:

- 使用参数 $\theta$ 进行拟合,让数据集中的值与拟合算出的值的差值平方$\sum_i(y^{(i)} − \theta^T x^{(i)} )^2$最小(最小二乘法的思想);

- 输出 $\theta^T x$ 。

相应地,在 LWR 局部加权线性回归方法中,步骤如下:

- 使用参数 $\theta$ 进行拟合,让加权距离$\sum_i w^{(i)}(y^{(i)} − \theta^T x^{(i)} )^2$ 最小;

- 输出 $\theta^T x$。

上面式子中的 $w^{(i)}$ 是非负的权值。直观点说就是,如果对应某个$i$ 的权值 $w^{(i)}$ 特别大,那么在选择拟合参数 $\theta$ 的时候,就要尽量让这一点的 $(y^{(i)} − \theta^T x^{(i)} )^2$ 最小。而如果权值$w^{(i)}$ 特别小,那么这一点对应的$(y^{(i)} − \theta^T x^{(i)} )^2$ 就基本在拟合过程中忽略掉了。

对于权值的选取可以使用下面这个比较标准的公式:$^4$

$$

w^{(i)} = exp(- \frac {(x^{(i)}-x)^2}{2\tau^2})

$$

4 如果 $x$ 是有值的向量,那就要对上面的式子进行泛化,得到的是$w^{(i)} = exp(− \frac {(x^{(i)}-x)^T(x^{(i)}-x)}{2\tau^2})$,或者:$w^{(i)} = exp(− \frac {(x^{(i)}-x)^T\Sigma ^{-1}(x^{(i)}-x)}{2})$,这就看是选择用$\tau$ 还是 $\Sigma$。

要注意的是,权值是依赖每个特定的点 $x$ 的,而这些点正是我们要去进行预测评估的点。此外,如果 $|x^{(i)} − x|$ 非常小,那么权值 $w^{(i)} $就接近 $1$;反之如果 $|x^{(i)} − x|$ 非常大,那么权值 $w^{(i)} $就变小。所以可以看出, $\theta$ 的选择过程中,查询点 $x$ 附近的训练样本有更高得多的权值。($\theta$is chosen giving a much higher “weight” to the (errors on) training examples close to the query point x.)(还要注意,当权值的方程的形式跟高斯分布的密度函数比较接近的时候,权值和高斯分布并没有什么直接联系,尤其是当权值不是随机值,且呈现正态分布或者其他形式分布的时候。)随着点$x^{(i)} $ 到查询点 $x$ 的距离降低,训练样本的权值的也在降低,参数$\tau$ 控制了这个降低的速度;$\tau$也叫做带宽参数,这个也是在你的作业中需要来体验和尝试的一个参数。

局部加权线性回归是咱们接触的第一个非参数 算法。而更早之前咱们看到的无权重的线性回归算法就是一种参数 学习算法,因为有固定的有限个数的参数(也就是 $\theta_i$ ),这些参数用来拟合数据。我们对 $\theta_i$ 进行了拟合之后,就把它们存了起来,也就不需要再保留训练数据样本来进行更进一步的预测了。与之相反,如果用局部加权线性回归算法,我们就必须一直保留着整个训练集。这里的非参数算法中的 非参数“non-parametric” 是粗略地指:为了呈现出假设 $h$ 随着数据集规模的增长而线性增长,我们需要以一定顺序保存一些数据的规模。(The term “non-parametric” (roughly) refers to the fact that the amount of stuff we need to keep in order to represent the hypothesis h grows linearly with the size of the training set. )

第二部分 分类和逻辑回归(Classification and logistic regression)

接下来咱们讲一下分类的问题。分类问题其实和回归问题很像,只不过我们现在要来预测的 $y$ 的值只局限于少数的若干个离散值。眼下咱们首先关注的是二值化分类 问题,也就是说咱们要判断的 $y$ 只有两个取值,$0$ 或者 $1$。(咱们这里谈到的大部分内容也都可以扩展到多种类的情况。)例如,假如要建立一个垃圾邮件筛选器,那么就可以用 $x^{(i)}$ 表示一个邮件中的若干特征,然后如果这个邮件是垃圾邮件,$y$ 就设为$1$,否则 $y$ 为 $0$。$0$ 也可以被称为消极类别(negative class),而 $1$ 就成为积极类别(positive class),有的情况下也分别表示成“-” 和 “+”。对于给定的一个 $x^{(i)}$,对应的$y^{(i)}$也称为训练样本的标签(label)。

5 逻辑回归(Logistic regression)

我们当然也可以还按照之前的线性回归的算法来根据给定的 $x$ 来预测 $y$,只要忽略掉 $y$ 是一个散列值就可以了。然而,这样构建的例子很容易遇到性能问题,这个方法运行效率会非常低,效果很差。而且从直观上来看,$h_\theta(x)$ 的值如果大于$1$ 或者小于$0$ 就都没有意义了,因为咱们已经实现都确定了 $y \in {0, 1}$,就是说 $y$ 必然应当是 $0$ 和 $1$ 这两个值当中的一个。

所以咱们就改变一下假设函数$h_\theta (x)$ 的形式,来解决这个问题。比如咱们可以选择下面这个函数:

$$

h_\theta(x) = g(\theta^T x) = \frac 1{1+e^{-\theta^Tx}}

$$

其中有:

$$

g(z)= \frac 1 {1+e^{-z}}

$$

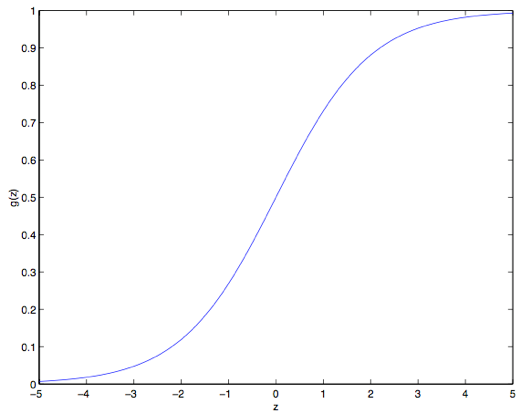

这个函数叫做逻辑函数 (Logistic function) ,或者也叫双弯曲S型函数(sigmoid function)。下图是 $g(z)$ 的函数图像:

注意到没有,当$z\to +\infty$ 的时候 $g(z)$ 趋向于$1$,而当$z\to -\infty$ 时$g(z)$ 趋向于$0$。此外,这里的这个 $g(z)$ ,也就是 $h(x)$,是一直在 $0$ 和 $1$ 之间波动的。然后咱们依然像最开始那样来设置 $x_0 = 1$,这样就有了:$\theta^T x =\theta_0 +\sum^n_{j=1}\theta_jx_j$

现在咱们就把 $g$ 作为选定的函数了。当然其他的从$0$到$1$之间光滑递增的函数也可以使用,不过后面我们会了解到选择 $g$ 的一些原因(到时候我们讲广义线性模型 GLMs,那时候还会讲生成学习算法,generative learning algorithms),对这个逻辑函数的选择是很自然的。再继续深入之前,下面是要讲解的关于这个 S 型函数的导数,也就是 $g’$ 的一些性质:

$$

\begin{aligned}

g’(z) & = \frac d{dz}\frac 1{1+e^{-z}}\

& = \frac 1{(1+e^{-z})^2}(e^{-z})\

& = \frac 1{(1+e^{-z})} \cdot (1- \frac 1{(1+e^{-z})})\

& = g(z)(1-g(z))\

\end{aligned}

$$

那么,给定了逻辑回归模型了,咱们怎么去拟合一个合适的 $\theta$ 呢?我们之前已经看到了在一系列假设的前提下,最小二乘法回归可以通过最大似然估计来推出,那么接下来就给我们的这个分类模型做一系列的统计学假设,然后用最大似然法来拟合参数吧。

首先假设:

$$

\begin{aligned}

P(y=1|x;\theta)&=h_{\theta}(x)\

P(y=0|x;\theta)&=1- h_{\theta}(x)\

\end{aligned}

$$

更简洁的写法是:

$$

p(y|x;\theta)=(h_\theta (x))^y(1- h_\theta (x))^{1-y}

$$

假设 $m$ 个训练样本都是各自独立生成的,那么就可以按如下的方式来写参数的似然函数:

$$

\begin{aligned}

L(\theta) &= p(\vec{y}| X; \theta)\

&= \prod^m_{i=1} p(y^{(i)}| x^{(i)}; \theta)\

&= \prod^m_{i=1} (h_\theta (x^{(i)}))^{y^{(i)}}(1-h_\theta (x^{(i)}))^{1-y^{(i)}} \

\end{aligned}

$$

然后还是跟之前一样,取个对数就更容易计算最大值:

$$

\begin{aligned}

l(\theta) &=\log L(\theta) \

&= \sum^m_{i=1} y^{(i)} \log h(x^{(i)})+(1-y^{(i)})\log (1-h(x^{(i)}))

\end{aligned}

$$

怎么让似然函数最大?就跟之前咱们在线性回归的时候用了求导数的方法类似,咱们这次就是用梯度上升法(gradient ascent)。还是写成向量的形式,然后进行更新,也就是$ \theta := \theta +\alpha \nabla _\theta l(\theta)$ 。 (注意更新方程中用的是加号而不是减号,因为我们现在是在找一个函数的最大值,而不是找最小值了。) 还是先从只有一组训练样本$(x,y)$ 来开始,然后求导数来推出随机梯度上升规则:

$$

\begin{aligned}

\frac {\partial}{\partial \theta_j} l(\theta) &=(y\frac 1 {g(\theta ^T x)} - (1-y)\frac 1 {1- g(\theta ^T x)} )\frac {\partial}{\partial \theta_j}g(\theta ^Tx) \

&= (y\frac 1 {g(\theta ^T x)} - (1-y)\frac 1 {1- g(\theta ^T x)} ) g(\theta^Tx)(1-g(\theta^Tx)) \frac {\partial}{\partial \theta_j}\theta ^Tx \

&= (y(1-g(\theta^Tx) ) -(1-y) g(\theta^Tx)) x_j\

&= (y-h_\theta(x))x_j

\end{aligned}

$$

上面的式子里,我们用到了对函数求导的定理 $ g’(z)= g(z)(1-g(z))$ 。然后就得到了随机梯度上升规则:

$$

\theta_j := \theta_j + \alpha (y^{(i)}-h_\theta (x^{(i)}))x_j^{(i)}

$$

如果跟之前的 LMS 更新规则相对比,就能发现看上去挺相似的;不过这并不是同一个算法,因为这里的$h_\theta(x^{(i)})$现在定义成了一个 $\theta^Tx^{(i)}$ 的非线性函数。尽管如此,我们面对不同的学习问题使用了不同的算法,却得到了看上去一样的更新规则,这个还是有点让人吃惊。这是一个巧合么,还是背后有更深层次的原因呢?在我们学到了 GLM 广义线性模型的时候就会得到答案了。(另外也可以看一下 习题集1 里面 Q3 的附加题。)

6 题外话: 感知器学习算法(The perceptron learning algorithm)

现在咱们来岔开一下话题,简要地聊一个算法,这个算法的历史很有趣,并且之后在我们讲学习理论的时候还要讲到它。设想一下,对逻辑回归方法修改一下,“强迫”它输出的值要么是 $0$ 要么是 $1$。要实现这个目的,很自然就应该把函数 $g$ 的定义修改一下,改成一个阈值函数(threshold function):

$$

g(z)= \begin{cases} 1 & if\quad z \geq 0 \

0 & if\quad z < 0 \end{cases}

$$

如果我们还像之前一样令 $h_\theta(x) = g(\theta^T x)$,但用刚刚上面的阈值函数作为 $g$ 的定义,然后如果我们用了下面的更新规则:

$$

\theta_j := \theta_j +\alpha(y^{(i)}-h_\theta (x^{(i)}))x_j^{(i)}

$$

这样我们就得到了感知器学习算法。

在 1960 年代,这个“感知器(perceptron)”被认为是对大脑中单个神经元工作方法的一个粗略建模。鉴于这个算法的简单程度,这个算法也是我们后续在本课程中讲学习理论的时候的起点。但一定要注意,虽然这个感知器学习算法可能看上去表面上跟我们之前讲的其他算法挺相似,但实际上这是一个和逻辑回归以及最小二乘线性回归等算法在种类上都完全不同的算法;尤其重要的是,很难对感知器的预测赋予有意义的概率解释,也很难作为一种最大似然估计算法来推出感知器学习算法。

7 让$l(\theta)$ 取最大值的另外一个算法

再回到用 S 型函数 $g(z)$ 来进行逻辑回归的情况,咱们来讲一个让 $l(\theta)$ 取最大值的另一个算法。

开始之前,咱们先想一下求一个方程零点的牛顿法。假如我们有一个从实数到实数的函数 $f:R \to R$,然后要找到一个 $\theta$ ,来满足 $f(\theta)=0$,其中 $\theta\in R$ 是一个实数。牛顿法就是对 $\theta$ 进行如下的更新:

$$

\theta := \theta - \frac {f(\theta)}{f’(\theta)}

$$

这个方法可以通过一个很自然的解释,我们可以把它理解成用一个线性函数来对函数 $f$ 进行逼近,这条直线是 $f$ 的切线,而猜测值是 $\theta$,解的方法就是找到线性方程等于零的点,把这一个零点作为 $\theta$ 设置给下一次猜测,然后以此类推。

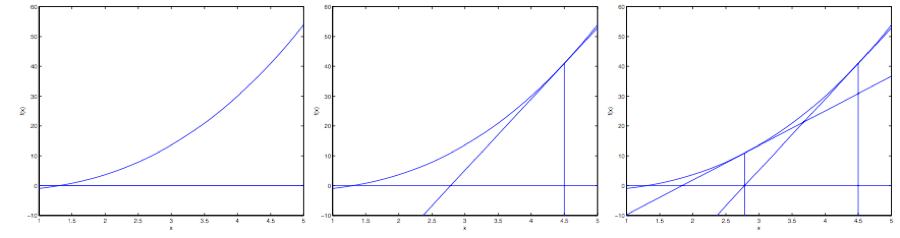

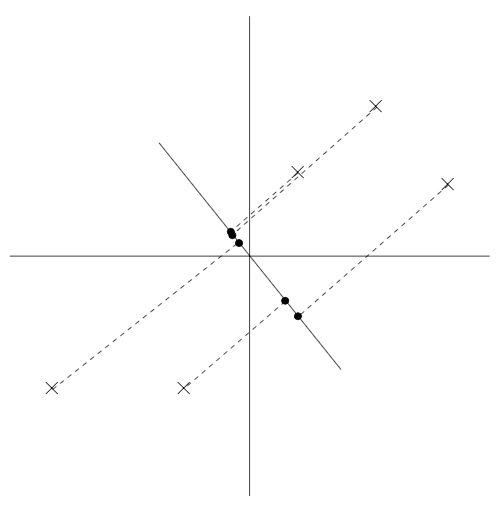

下面是对牛顿法的图解:

在最左边的图里面,可以看到函数 $f$ 就是沿着 $y=0$ 的一条直线。这时候是想要找一个 $\theta$ 来让 $f(\theta)=0$。这时候发现这个 $\theta$ 值大概在 $1.3$ 左右。加入咱们猜测的初始值设定为 $\theta=4.5$。牛顿法就是在 $\theta=4.5$ 这个位置画一条切线(中间的图)。这样就给出了下一个 $\theta$ 猜测值的位置,也就是这个切线的零点,大概是$2.8$。最右面的图中的是再运行一次这个迭代产生的结果,这时候 $\theta$ 大概是$1.8$。就这样几次迭代之后,很快就能接近 $\theta=1.3$。

牛顿法的给出的解决思路是让 $f(\theta) = 0$ 。如果咱们要用它来让函数 $l$ 取得最大值能不能行呢?函数 $l$ 的最大值的点应该对应着是它的导数$l’(\theta)$ 等于零的点。所以通过令$f(\theta) = l’(\theta)$,咱们就可以同样用牛顿法来找到 $l$ 的最大值,然后得到下面的更新规则:

$$

\theta := \theta - \frac {l’(\theta)}{l’’(\theta)}

$$

(扩展一下,额外再思考一下: 如果咱们要用牛顿法来求一个函数的最小值而不是最大值,该怎么修改?)译者注:试试法线的零点

最后,在咱们的逻辑回归背景中,$\theta$ 是一个有值的向量,所以我们要对牛顿法进行扩展来适应这个情况。牛顿法进行扩展到多维情况,也叫牛顿-拉普森法(Newton-Raphson method),如下所示:

$$

\theta := \theta - H^{-1}\nabla_\theta l(\theta)

$$

上面这个式子中的 $\nabla_\theta l(\theta)$和之前的样例中的类似,是关于 $\theta_i$ 的 $l(\theta)$ 的偏导数向量;而 $h$ 是一个 $n\times n$ 矩阵 ,实际上如果包含截距项的话,应该是, $(n + 1)\times (n + 1)$,也叫做 Hessian, 其详细定义是:

$$

H_{ij}= \frac {\partial^2 l(\theta)}{\partial \theta_i \partial \theta_j}

$$

牛顿法通常都能比(批量)梯度下降法收敛得更快,而且达到最小值所需要的迭代次数也低很多。然而,牛顿法中的单次迭代往往要比梯度下降法的单步耗费更多的性能开销,因为要查找和转换一个 $n\times n$的 Hessian 矩阵;不过只要这个 $n$ 不是太大,牛顿法通常就还是更快一些。当用牛顿法来在逻辑回归中求似然函数$l(\theta)$ 的最大值的时候,得到这一结果的方法也叫做Fisher评分(Fisher scoring)。

第三部分 广义线性模型 (Generalized Linear Models)$^5$

5 本节展示的内容受以下两份作品的启发:Michael I. Jordan, Learning in graphical models (unpublished book draft), 以及 McCullagh and Nelder, Generalized Linear Models (2nd ed.)。

到目前为止,我们看过了回归的案例,也看了一个分类案例。在回归的案例中,我们得到的函数是 $y|x; \theta ∼ N (\mu, \sigma^2)$;而分类的案例中,函数是 $y|x; \theta ∼ Bernoulli(\phi)$,这里面的$\mu$ 和 $\phi$ 分别是 $x$ 和 $\theta$ 的某种函数。在本节,我们会发现这两种方法都是一个更广泛使用的模型的特例,这种更广泛使用的模型就叫做广义线性模型。我们还会讲一下广义线性模型中的其他模型是如何推出的,以及如何应用到其他的分类和回归问题上。

8 指数族 (The exponential family)

在学习 GLMs 之前,我们要先定义一下指数组分布(exponential family distributions)。如果一个分布能用下面的方式来写出来,我们就说这类分布属于指数族:

$$

p(y;\eta) =b(y)exp(\eta^TT(y)-a(\eta)) \qquad \text{(6)}

$$

上面的式子中,$\eta$ 叫做此分布的自然参数 (natural parameter,也叫典范参数 canonical parameter) ; $T(y)$ 叫做充分统计量(sufficient statistic) ,我们目前用的这些分布中通常 $T (y) = y$;而 $a(\eta)$ 是一个对数分割函数(log partition function)。 $e^{−a(\eta)}$ 这个量本质上扮演了归一化常数(normalization constant)的角色,也就是确保 $p(y; \eta)$ 的总和或者积分等于$1$。

当给定 $T$, $a$ 和 $b$ 时,就定义了一个用 $\eta$ 进行参数化的分布族(family,或者叫集 set);通过改变 $\eta$,我们就能得到这个分布族中的不同分布。

现在咱们看到的伯努利(Bernoulli)分布和高斯(Gaussian)分布就都属于指数分布族。伯努利分布的均值是$\phi$,也写作 $Bernoulli(\phi)$,确定的分布是 $y \in {0, 1}$,因此有 $p(y = 1; \phi) = \phi$; $p(y = 0;\phi) = 1−\phi$。这时候只要修改$\phi$,就能得到一系列不同均值的伯努利分布了。现在我们展示的通过修改$\phi$,而得到的这种伯努利分布,就属于指数分布族;也就是说,只要给定一组 $T$,$a$ 和 $b$,就可以用上面的等式$(6)$来确定一组特定的伯努利分布了。

我们这样来写伯努利分布:

$$

\begin{aligned}

p(y;\phi) & = \phi ^y(1-\phi)^{1-y}\

& = exp(y \log \phi + (1-y)\log(1-\phi))\

& = exp( (log (\frac {\phi}{1-\phi}))y+\log (1-\phi) )\

\end{aligned}

$$

因此,自然参数(natural parameter)就给出了,即 $\eta = log (\frac \phi {1 − \phi})$。 很有趣的是,如果我们翻转这个定义,用$\eta$ 来解 $\phi$ 就会得到 $\phi = 1/ (1 + e^{−\eta} )$。这正好就是之前我们刚刚见到过的 S型函数(sigmoid function)!在我们把逻辑回归作为一种广义线性模型(GLM)的时候还会得到:

$$

\begin{aligned}

T(y) &= y \

a( \eta) & = - \log (1- \phi) \

& = \log {(1+ e^ \eta)}\

b(y)&=1

\end{aligned}

$$

上面这组式子就表明了伯努利分布可以写成等式$(6)$的形式,使用一组合适的$T$, $a$ 和 $b$。

接下来就看看高斯分布吧。还记得吧,在推导线性回归的时候,$\sigma^2$ 的值对我们最终选择的 $\theta$ 和 $h_\theta(x)$ 都没有影响。所以我们可以给 $\sigma^2$ 取一个任意值。为了简化推导过程,就令$\sigma^2 = 1$。$^6$然后就有了下面的等式:

$$

\begin{aligned}

p(y;\mu) &= \frac 1{\sqrt{2\pi}} exp (- \frac 12 (y-\mu)^2) \

& = \frac 1{\sqrt{2\pi}} exp (- \frac 12 y^2) \cdot exp (\mu y -\frac 12 \mu^2) \

\end{aligned}

$$

6 如果我们把 $\sigma^2$ 留作一个变量,高斯分布就也可以表达成指数分布的形式,其中 $\eta \in R^2$ 就是一个二维向量,同时依赖 $\mu$ 和 $\sigma$。然而,对于广义线性模型GLMs方面的用途, $\sigma^2$ 参数也可以看成是对指数分布族的更泛化的定义: $p(y; \eta, \tau ) = b(a, \tau ) exp((\eta^T T (y) − a(\eta))/c(\tau))$。这里面的$\tau$ 叫做分散度参数(dispersion parameter),对于高斯分布, $c(\tau) = \sigma^2$ ;不过上文中我们已经进行了简化,所以针对我们要考虑的各种案例,就不需要再进行更加泛化的定义了。

这样,我们就可以看出来高斯分布是属于指数分布族的,可以写成下面这样:

$$

\begin{aligned}

\eta & = \mu \

T(y) & = y \

a(\eta) & = \mu ^2 /2\

& = \eta ^2 /2\

b(y) & = (1/ \sqrt {2\pi })exp(-y^2/2)

\end{aligned}

$$

指数分布族里面还有很多其他的分布:

- 例如多项式分布(multinomial),这个稍后我们会看到;

- 泊松分布(Poisson),用于对计数类数据进行建模,后面再问题集里面也会看到;

- 伽马和指数分布(the gamma and the exponential),这个用于对连续的、非负的随机变量进行建模,例如时间间隔;

- 贝塔和狄利克雷分布(the beta and the Dirichlet),这个是用于概率的分布;

- 还有很多,这里就不一一列举了。

在下一节里面,我们就来讲一讲对于建模的一个更通用的“方案”,其中的$y$ (给定 $x$ 和 $\theta$)可以是上面这些分布中的任意一种。

9 构建广义线性模型(Constructing GLMs)

设想你要构建一个模型,来估计在给定的某个小时内来到你商店的顾客人数(或者是你的网站的页面访问次数),基于某些确定的特征 $x$ ,例如商店的促销、最近的广告、天气、今天周几啊等等。我们已经知道泊松分布(Poisson distribution)通常能适合用来对访客数目进行建模。知道了这个之后,怎么来建立一个模型来解决咱们这个具体问题呢?非常幸运的是,泊松分布是属于指数分布族的一个分布,所以我们可以对该问题使用广义线性模型(Generalized Linear Model,缩写为 GLM)。在本节,我们讲一种对刚刚这类问题构建广义线性模型的方法。

进一步泛化,设想一个分类或者回归问题,要预测一些随机变量 $y$ 的值,作为 $x$ 的一个函数。要导出适用于这个问题的广义线性模型,就要对我们的模型、给定 $x$ 下 $y$ 的条件分布来做出以下三个假设:

$y | x; \theta ∼ Exponential Family(\eta)$,即给定 $x$ 和 $\theta, y$ 的分布属于指数分布族,是一个参数为 $\eta$ 的指数分布。——假设1给定 $x$,目的是要预测对应这个给定 $x$ 的 $T(y)$ 的期望值。咱们的例子中绝大部分情况都是 $T(y) = y$,这也就意味着我们的学习假设 $h$ 输出的预测值 $h(x)$ 要满足 $h(x) = E[y|x]$。 (注意,这个假设通过对 $h_\theta(x)$ 的选择而满足,在逻辑回归和线性回归中都是如此。例如在逻辑回归中, $h_\theta (x) = [p (y = 1|x; \theta)] =[ 0 \cdot p (y = 0|x; \theta)+1\cdot p(y = 1|x;\theta)] = E[y|x;\theta]$。**译者注:这里的$E[y|x$]应该就是对给定$x$时的$y$值的期望的意思。**)——假设2自然参数 $\eta$ 和输入值 $x$ 是线性相关的,$\eta = \theta^T x$,或者如果 $\eta$ 是有值的向量,则有$\eta_i = \theta_i^T x$。——假设3

上面的几个假设中,第三个可能看上去证明得最差,所以也更适合把这第三个假设看作是一个我们在设计广义线性模型时候的一种 “设计选择 design choice”,而不是一个假设。那么这三个假设/设计,就可以用来推导出一个非常合适的学习算法类别,也就是广义线性模型 GLMs,这个模型有很多特别友好又理想的性质,比如很容易学习。此外,这类模型对一些关于 $y$ 的分布的不同类型建模来说通常效率都很高;例如,我们下面就将要简单介绍一些逻辑回归以及普通最小二乘法这两者如何作为广义线性模型来推出。

9.1 普通最小二乘法(Ordinary Least Squares)

我们这一节要讲的是普通最小二乘法实际上是广义线性模型中的一种特例,设想如下的背景设置:目标变量 $y$(在广义线性模型的术语也叫做响应变量response variable)是连续的,然后我们将给定 $x$ 的 $y$ 的分布以高斯分布 $N(\mu, \sigma^2)$ 来建模,其中 $\mu$ 可以是依赖 $x$ 的一个函数。这样,我们就让上面的$ExponentialFamily(\eta)$分布成为了一个高斯分布。在前面内容中我们提到过,在把高斯分布写成指数分布族的分布的时候,有$\mu = \eta$。所以就能得到下面的等式:

$$

\begin{aligned}

h_\theta(x)& = E[y|x;\theta] \

& = \mu \

& = \eta \

& = \theta^Tx\

\end{aligned}

$$

第一行的等式是基于假设2;第二个等式是基于定理当 $y|x; \theta ∼ N (\mu, \sigma ^2)$,则 $y$ 的期望就是 $\mu$ ;第三个等式是基于假设1,以及之前我们此前将高斯分布写成指数族分布的时候推导出来的性质 $\mu = \eta$;最后一个等式就是基于假设3。

9.2 逻辑回归(Logistic Regression)

接下来咱们再来看看逻辑回归。这里咱们还是看看二值化分类问题,也就是 $y \in {0, 1}$。给定了$y$ 是一个二选一的值,那么很自然就选择伯努利分布(Bernoulli distribution)来对给定 $x$ 的 $y$ 的分布进行建模了。在我们把伯努利分布写成一种指数族分布的时候,有 $\phi = 1/ (1 + e^{−\eta})$。另外还要注意的是,如果有 $y|x; \theta ∼ Bernoulli(\phi)$,那么 $E [y|x; \theta] = \phi$。所以就跟刚刚推导普通最小二乘法的过程类似,有以下等式:

$$

\begin{aligned}

h_\theta(x)& = E[y|x;\theta] \

& = \phi \

& = 1/(1+ e^{-\eta}) \

& = 1/(1+ e^{-\theta^Tx})\

\end{aligned}

$$

所以,上面的等式就给了给了假设函数的形式:$h_\theta(x) = 1/ (1 + e^{−\theta^T x})$。如果你之前好奇咱们是怎么想出来逻辑回归的函数为$1/ (1 + e^{−z} )$,这个就是一种解答:一旦我们假设以 $x$ 为条件的 $y$ 的分布是伯努利分布,那么根据广义线性模型和指数分布族的定义,就会得出这个式子。

再解释一点术语,这里给出分布均值的函数 $g$ 是一个关于自然参数的函数,$g(\eta) = E[T(y); \eta]$,这个函数也叫做规范响应函数(canonical response function), 它的反函数 $g^{−1}$ 叫做规范链接函数(canonical link function)。 因此,对于高斯分布来说,它的规范响应函数正好就是识别函数(identify function);而对于伯努利分布来说,它的规范响应函数则是逻辑函数(logistic function)。$^7$

7 很多教科书用 $g$ 表示链接函数,而用反函数$g^{−1}$ 来表示响应函数;但是咱们这里用的是反过来的,这是继承了早期的机器学习中的用法,我们这样使用和后续的其他课程能够更好地衔接起来。

9.3 Softmax 回归

咱们再来看一个广义线性模型的例子吧。设想有这样的一个分类问题,其中响应变量 $y$ 的取值可以是 $k$ 个值当中的任意一个,也就是 $y \in {1, 2, …, k}$。例如,我们这次要进行的分类就比把邮件分成垃圾邮件和正常邮件两类这种二值化分类要更加复杂一些,比如可能是要分成三类,例如垃圾邮件、个人邮件、工作相关邮件。这样响应变量依然还是离散的,但取值就不只有两个了。因此咱们就用多项式分布(multinomial distribution)来进行建模。

下面咱们就通过这种多项式分布来推出一个广义线性模型。要实现这一目的,首先还是要把多项式分布也用指数族分布来进行描述。

要对一个可能有 $k$ 个不同输出值的多项式进行参数化,就可以用 $k$ 个参数 $\phi_1,…,\phi_ k$ 来对应各自输出值的概率。不过这么多参数可能太多了,形式上也太麻烦,他们也未必都是互相独立的(比如对于任意一个$\phi_ i$中的值来说,只要知道其他的 $k-1$ 个值,就能知道这最后一个了,因为总和等于$1$,也就是$\sum^k_{i=1} \phi_i = 1$)。所以咱们就去掉一个参数,只用 $k-1$ 个:$\phi_1,…,\phi_ {k-1}$ 来对多项式进行参数化,其中$\phi_i = p (y = i; \phi),p (y = k; \phi) = 1 −\sum ^{k−1}{i=1}\phi i$。为了表述起来方便,我们还要设 $\phi_k = 1 − \sum_{i=1}^{k−1} \phi_i$,但一定要注意,这个并不是一个参数,而是完全由其他的 $k-1$ 个参数来确定的。

要把一个多项式表达成为指数组分布,还要按照下面的方式定义一个 $T (y) \in R^{k−1}$:

$$

T(1)=

\begin{bmatrix}

1\

0\

0\

\vdots \

0\

\end{bmatrix},

T(2)=

\begin{bmatrix}

0\

1\

0\

\vdots \

0\

\end{bmatrix},

T(3)=

\begin{bmatrix}

0\

0\

1\

\vdots \

0\

\end{bmatrix},

T(k-1)=

\begin{bmatrix}

0\

0\

0\

\vdots \

1\

\end{bmatrix},

T(k)=

\begin{bmatrix}

0\

0\

0\

\vdots \

0\

\end{bmatrix},

$$

这次和之前的样例都不一样了,就是不再有 $T(y) = y$;然后,$T(y)$ 现在是一个 $k – 1$ 维的向量,而不是一个实数了。向量 $T(y)$ 中的第 $i$ 个元素写成$(T(y))_i$ 。

现在介绍一种非常有用的记号。指示函数(indicator function)$1{\cdot }$,如果参数为真,则等于$1$;反之则等于$0$($1{True} = 1, 1{False} = 0$)。例如$1{2 = 3} = 0$, 而$1{3 = 5 − 2} = 1$。所以我们可以把$T(y)$ 和 $y$ 的关系写成 $(T(y))_i = 1{y = i}$。(往下继续阅读之前,一定要确保你理解了这里的表达式为真!)在此基础上,就有了$E[(T(y))_i] = P (y = i) = \phi_i$。

现在一切就绪,可以把多项式写成指数族分布了。写出来如下所示:

$$

\begin{aligned}

p(y;\phi) &=\phi_1^{1{y=1}}\phi_2^{1{y=2}}\dots \phi_k^{1{y=k}} \

&=\phi_1^{1{y=1}}\phi_2^{1{y=2}}\dots \phi_k^{1-\sum_{i=1}^{k-1}1{y=i}} \

&=\phi_1^{(T(y))_1}\phi_2^{(T(y))2}\dots \phi_k^{1-\sum{i=1}^{k-1}(T(y))_i } \

&=exp((T(y))_1 log(\phi_1)+(T(y))2 log(\phi_2)+\dots+(1-\sum{i=1}^{k-1}(T(y))_i)log(\phi_k)) \

&= exp((T(y))1 log(\frac{\phi_1}{\phi_k})+(T(y))2 log(\frac{\phi_2}{\phi_k})+\dots+(T(y)){k-1}log(\frac{\phi{k-1}}{\phi_k})+log(\phi_k)) \

&=b(y)exp(\eta^T T(y)-a(\eta))

\end{aligned}

$$

其中:

$$

\begin{aligned}

\eta &=

\begin{bmatrix}

\log (\phi _1/\phi _k)\

\log (\phi _2/\phi _k)\

\vdots \

\log (\phi _{k-1}/\phi _k)\

\end{bmatrix}, \

a(\eta) &= -\log (\phi _k)\

b(y) &= 1\

\end{aligned}

$$

这样咱们就把多项式方程作为一个指数族分布来写了出来。

与 $i (for\quad i = 1, …, k)$对应的链接函数为:

$$

\eta_i =\log \frac {\phi_i}{\phi_k}

$$

为了方便起见,我们再定义 $\eta_k = \log (\phi_k/\phi_k) = 0$。对链接函数取反函数然后推导出响应函数,就得到了下面的等式:

$$

\begin{aligned}

e^{\eta_i} &= \frac {\phi_i}{\phi_k}\

\phi_k e^{\eta_i} &= \phi_i \qquad\text{(7)}\

\phi_k \sum^k_{i=1} e^{\eta_i}&= \sum^k_{i=1}\phi_i= 1\

\end{aligned}

$$

这就说明了$\phi_k = \frac 1 {\sum^k_{i=1} e^{\eta_i}}$,然后可以把这个关系代入回到等式$(7)$,这样就得到了响应函数:

$$

\phi_i = \frac { e^{\eta_i} }{ \sum^k_{j=1} e^{\eta_j}}

$$

上面这个函数从$\eta$ 映射到了$\phi$,称为 Softmax 函数。

要完成我们的建模,还要用到前文提到的假设3,也就是 $\eta_i$ 是一个 $x$ 的线性函数。所以就有了 $\eta_i= \theta_i^Tx (for\quad i = 1, …, k − 1)$,其中的 $\theta_1, …, \theta_{k−1} \in R^{n+1}$ 就是我们建模的参数。为了表述方便,我们这里还是定义$\theta_k = 0$,这样就有 $\eta_k = \theta_k^T x = 0$,跟前文提到的相符。因此,我们的模型假设了给定 $x$ 的 $y$ 的条件分布为:

$$

\begin{aligned}

p(y=i|x;\theta) &= \phi_i \

&= \frac {e^{\eta_i}}{\sum^k_{j=1}e^{\eta_j}}\

&=\frac {e^{\theta_i^Tx}}{\sum^k_{j=1}e^{\theta_j^Tx}}\qquad\text{(8)}\

\end{aligned}

$$

这个适用于解决 $y \in{1, …, k}$ 的分类问题的模型,就叫做 Softmax 回归。 这种回归是对逻辑回归的一种扩展泛化。

假设(hypothesis) $h$ 则如下所示:

$$

\begin{aligned}

h_\theta (x) &= E[T(y)|x;\theta]\

&= E \left[

\begin{array}{cc|c}

1(y=1)\

1(y=2)\

\vdots \

1(y=k-1)\

\end{array}x;\theta

\right]\

&= E \left[

\begin{array}{c}

\phi_1\

\phi_2\

\vdots \

\phi_{k-1}\

\end{array}

\right]\

&= E \left[

\begin{array}{ccc}

\frac {exp(\theta_1^Tx)}{\sum^k_{j=1}exp(\theta_j^Tx)} \

\frac {exp(\theta_2^Tx)}{\sum^k_{j=1}exp(\theta_j^Tx)} \

\vdots \

\frac {exp(\theta_{k-1}^Tx)}{\sum^k_{j=1}exp(\theta_j^Tx)} \

\end{array}

\right]\

\end{aligned}

$$

也就是说,我们的假设函数会对每一个 $i = 1,…,k$ ,给出 $p (y = i|x; \theta)$ 概率的估计值。(虽然咱们在前面假设的这个 $h_\theta(x)$ 只有 $k-1$ 维,但很明显 $p (y = k|x; \theta)$ 可以通过用 $1$ 减去其他所有项目概率的和来得到,即$1− \sum^{k-1}_{i=1}\phi_i$。)

最后,咱们再来讲一下参数拟合。和我们之前对普通最小二乘线性回归和逻辑回归的原始推导类似,如果咱们有一个有 $m$ 个训练样本的训练集 ${(x^{(i)}, y^{(i)}); i = 1, …, m}$,然后要研究这个模型的参数 $\theta_i$ ,我们可以先写出其似然函数的对数:

$$

\begin{aligned}

l(\theta)& =\sum^m_{i=1} \log p(y^{(i)}|x^{(i)};\theta)\

&= \sum^m_{i=1}log\prod ^k_{l=1}(\frac {e^{\theta_l^Tx^{(i)}}}{\sum^k_{j=1} e^{\theta_j^T x^{(i)}}})^{1(y^{(i)}=l)}\

\end{aligned}

$$

要得到上面等式的第二行,要用到等式$(8)$中的设定 $p(y|x; \theta)$。现在就可以通过对 $l(\theta)$ 取最大值得到的 $\theta$ 而得到对参数的最大似然估计,使用的方法就可以用梯度上升法或者牛顿法了。

第二章

第四部分 生成学习算法(Generative Learning algorithms)

目前为止,我们讲过的学习算法的模型都是$p (y|x;\theta)$,也就是给定 $x$ 下 $y$ 的条件分布,以 $\theta$ 为参数。例如,逻辑回归中就是以 $h_\theta(x) = g(\theta^T x)$ 作为 $p (y|x;\theta)$ 的模型,这里的 $g$ 是一个 $S$型函数(sigmoid function)。接下来,咱们要讲一下一种不同类型的学习算法。

设想有这样一种分类问题,我们要学习基于一个动物的某个特征来辨别它是大象$(y=1)$还是小狗$(y=0)$。给定一个训练集,用逻辑回归或者基础版的感知器算法(perceptron algorithm) 这样的一个算法能找到一条直线,作为区分开大象和小狗的边界。接下来,要辨别一个新的动物是大象还是小狗,程序就要检查这个新动物的值落到了划分出来的哪个区域中,然后根据所落到的区域来给出预测。

还有另外一种方法。首先,观察大象,然后我们针对大象的样子来进行建模。然后,再观察小狗,针对小狗的样子另外建立一个模型。最后要判断一种新动物归属哪一类,我们可以把新动物分别用大象和小狗的模型来进比对,看看新动物更接近哪个训练集中已有的模型。

例如逻辑回归之类的直接试图建立 $p(y|x)$的算法,以及感知器算法(perceptron algorithm)等直接用投图(mappings directly)的思路来判断对应 $X$ 的值落到了 ${0, 1}$ 中哪个区域的算法,这些都叫判别式学习算法(discriminative learning algorithms)。 和之前的这些判别式算法不同,下面我们要讲的新算法是对 $p(x|y)$ 和 $p(y)$来进行建模。这类算法叫做生成学习算法(generative learning algorithms)。例如如果 $y$ 用来表示一个样例是 小狗 $(0)$ 或者 大象 $(1)$,那么$p(x|y = 0)$就是对小狗特征分布的建模,而$p(x|y = 1)$就是对大象特征分布的建模。

对 $p(y)$ (通常称为class priors译者注:这里没有找到合适的词进行翻译) 和$p(x|y)$ 进行建模之后,我们的算法就是用贝叶斯规则(Bayes rule) 来推导对应给定 $x$ 下 $y$ 的后验分布(posterior distribution):

$$

p(y|x)=\frac{p(x|y)p(y)}{p(x)}

$$

这里的分母(denominator) 为:$p(x) = p(x|y = 1)p(y = 1) + p(x|y = 0)p(y = 0)$(这个等式关系可以根据概率的标准性质来推导验证译者注:其实就是条件概率),这样接下来就可以把它表示成我们熟悉的 $p(x|y)$和 $p(y)$ 的形式了。实际上如果我们计算$p(y|x)$ 来进行预测,那就并不需要去计算这个分母,因为有下面的等式关系:

$$\begin{aligned}

\arg \max_y p(y|x) & =\arg \max_y \frac{p(x|y)p(y)}{p(x)}\

&= \arg \max_y p(x|y)p(y)

\end{aligned}$$

1 高斯判别分析(Gaussian discriminant analysis)

咱们要学的第一个生成学习算法就是高斯判别分析(Gaussian discriminant analysis ,缩写为GDA。译者注:高斯真棒!)在这个模型里面,我们假设 $p(x|y)$是一个多元正态分布。 所以首先咱们简单讲一下多元正态分布的一些特点,然后再继续讲 GDA 高斯判别分析模型。

1.1 多元正态分布(multivariate normal distribution)

$n$维多元正态分布,也叫做多变量高斯分布,参数为一个$n$维 均值向量 $\mu \in R^n $,以及一个 协方差矩阵 $\Sigma \in R^{n\times n}$,其中$\Sigma \geq 0$ 是一个对称(symmetric)的半正定(positive semi-definite)矩阵。当然也可以写成”$N (\mu, \Sigma)$” 的分布形式,密度(density)函数为:

$$

p(x;\mu,\Sigma)=\frac{1}{(2\pi)^{n/2}|\Sigma|^{1/2}} exp(-\frac{1}{2}(x-\mu)^T\Sigma^{-1}(x-\mu))

$$

在上面的等式中,”$|\Sigma|$”的意思是矩阵$\Sigma$的行列式(determinant)。对于一个在 $N(\mu,\Sigma)$分布中的随机变量 $X$ ,其平均值(跟正态分布里面差不多,所以并不意外)就是 $\mu$ 了:

$$

E[X]=\int_x xp(x;\mu,\Sigma)dx=\mu

$$

随机变量$Z$是一个有值的向量(vector-valued random variable),$Z$ 的 协方差(covariance) 的定义是:$Cov(Z) = E[(Z-E[Z])(Z-E[Z])^T ]$。这是对实数随机变量的方差(variance)这一概念的泛化扩展。这个协方差还可以定义成$Cov(Z) = E[ZZ^T]-(E[Z])(E[Z])^T$(你可以自己证明一下这两个定义实际上是等价的。)如果 $X$ 是一个多变量正态分布,即 $X \sim N (\mu, \Sigma)$,则有:

$$

Cov(X)=\Sigma

$$

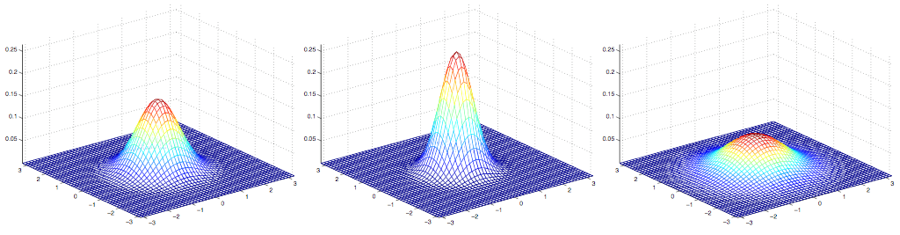

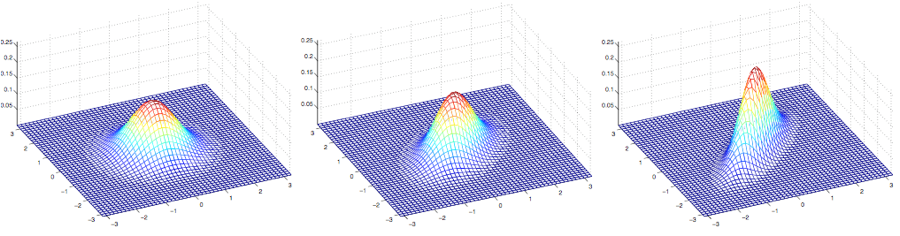

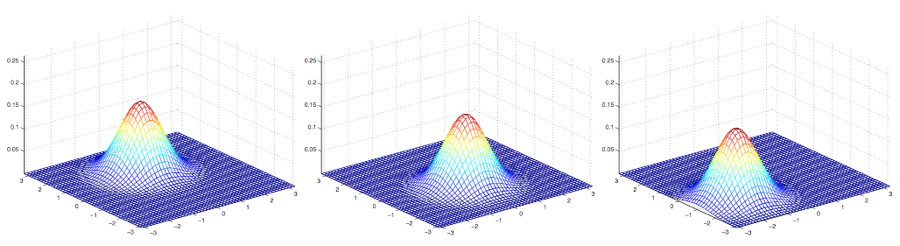

下面这些样例是一些高斯分布的密度图,如下图所示:

最左边的图,展示的是一个均值为$0$(实际上是一个$2\times 1$ 的零向量)的高斯分布,协方差矩阵就是$\Sigma = I$ (一个 $2\times 2$的单位矩阵,identity matrix)。这种均值为$0$ 并且协方差矩阵为单位矩阵的高斯分布也叫做标准正态分布。 中间的图中展示的是均值为$0$而协方差矩阵是$0.6I$ 的高斯分布的概率密度函数;最右边的展示的是协方差矩阵$\Sigma = 2I$的高斯分布的概率密度函数。从这几个图可以看出,随着协方差矩阵$\Sigma$变大,高斯分布的形态就变得更宽平(spread-out),而如果协方差矩阵$\Sigma$变小,分布就会更加集中(compressed)。

来看一下更多的样例:

上面这几个图展示的是均值为$0$,但协方差矩阵各不相同的高斯分布,其中的协方差矩阵依次如下所示:

$$

\Sigma =\begin{bmatrix}

1 & 0 \ 0 & 1 \ \end{bmatrix};

\Sigma =\begin{bmatrix}

1 & 0.5 \ 0.5 & 1 \

\end{bmatrix};

\Sigma =\begin{bmatrix}

1 & 0.8 \ 0.8 & 1 \

\end{bmatrix}

$$

第一幅图还跟之前的标准正态分布的样子很相似,然后我们发现随着增大协方差矩阵$\Sigma$ 的反对角线(off-diagonal)的值,密度图像开始朝着 45° 方向 (也就是 $x_1 = x_2$ 所在的方向)逐渐压缩(compressed)。 看一下三个同样分布密度图的轮廓图(contours)能看得更明显:

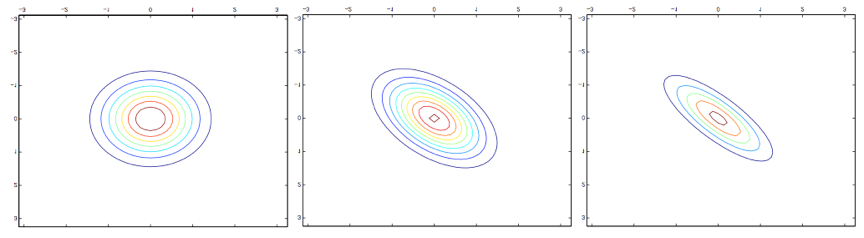

下面的是另外一组样例,调整了协方差矩阵$\Sigma$:

$$

\Sigma =\begin{bmatrix}

1 & 0.5 \ 0.5 & 1 \

\end{bmatrix};

\Sigma =\begin{bmatrix}

1 & 0.8 \ 0.8 & 1 \

\end{bmatrix}

\Sigma =\begin{bmatrix}

3 & 0.8 \ 0.8 & 1 \ \end{bmatrix};

$$

上面这三个图像对应的协方差矩阵分别如下所示:

从最左边的到中间译者注:注意,左边和中间的这两个协方差矩阵中,右上和左下的元素都是负值!很明显随着协方差矩阵中右上左下这个对角线方向元素的值的降低,图像还是又被压扁了(compressed),只是方向是反方向的。最后,随着我们修改参数,通常生成的轮廓图(contours)都是椭圆(最右边的图就是一个例子)。

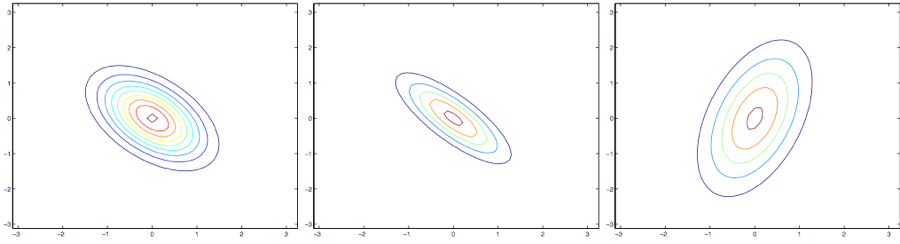

再举一些例子,固定协方差矩阵为单位矩阵,即$\Sigma = I$,然后调整均值$\mu$,我们就可以让密度图像随着均值而移动:

上面的图像中协方差矩阵都是单位矩阵,即 $\Sigma = I$,对应的均值$\mu$如下所示:

$$

\mu =\begin{bmatrix}

1 \ 0 \

\end{bmatrix};

\mu =\begin{bmatrix}

-0.5 \ 0 \

\end{bmatrix};

\mu =\begin{bmatrix}

-1 \ -1.5 \

\end{bmatrix};

$$

1.2 高斯判别分析模型(Gaussian Discriminant Analysis model)

假如我们有一个分类问题,其中输入特征 $x$ 是一系列的连续随机变量(continuous-valued random variables),那就可以使用高斯判别分析(Gaussian Discriminant Analysis ,缩写为 GDA)模型,其中对 $p(x|y)$用多元正态分布来进行建模。这个模型为:

$$

\begin{aligned}

y & \sim Bernoulli(\phi)\

x|y = 0 & \sim N(\mu_o,\Sigma)\

x|y = 1 & \sim N(\mu_1,\Sigma)\

\end{aligned}

$$

分布写出来的具体形式如下:

$$

\begin{aligned}

p(y) & =\phi^y (1-\phi)^{1-y}\

p(x|y=0) & = \frac{1}{(2\pi)^{n/2}|\Sigma|^{1/2}} exp ( - \frac{1}{2}(x-\mu_0)^T\Sigma^{-1}(x-\mu_0) )\

p(x|y=1) & = \frac{1}{(2\pi)^{n/2}|\Sigma|^{1/2}} exp ( - \frac{1}{2}(x-\mu_1)^T\Sigma^{-1}(x-\mu_1) )\

\end{aligned}

$$

在上面的等式中,模型的参数包括$\phi, \Sigma, \mu_0 和 \mu_1$。(要注意,虽然这里有两个不同方向的均值向量$\mu_0$ 和 $\mu_1$,针对这个模型还是一般只是用一个协方差矩阵$\Sigma$。)取对数的似然函数(log-likelihood)如下所示:

$$

\begin{aligned}

l(\phi,\mu_0,\mu_1,\Sigma) &= \log \prod^m_{i=1}p(x^{(i)},y^{(i)};\phi,\mu_0,\mu_1,\Sigma)\

&= \log \prod^m_{i=1}p(x^{(i)}|y^{(i)};\mu_0,\mu_1,\Sigma)p(y^{(i)};\phi)\

\end{aligned}

$$

通过使 $l$ 取得最大值,找到对应的参数组合,然后就能找到该参数组合对应的最大似然估计,如下所示(参考习题集1):

$$

\begin{aligned}

\phi & = \frac {1}{m} \sum^m_{i=1}1{y^{(i)}=1}\

\mu_0 & = \frac{\sum^m_{i=1}1{y^{(i)}=0}x^{(i)}}{\sum^m_{i=1}1{y^{(i)}=0}}\

\mu_1 & = \frac{\sum^m_{i=1}1{y^{(i)}=1}x^{(i)}}{\sum^m_{i=1}1{y^{(i)}=1}}\

\Sigma & = \frac{1}{m}\sum^m_{i=1}(x^{(i)}-\mu_{y^{(i)}})(x^{(i)}-\mu_{y^{(i)}})^T\

\end{aligned}

$$

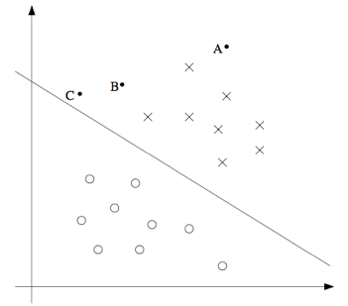

用图形化的方式来表述,这个算法可以按照下面的图示所表示:

图中展示的点就是训练数据集,图中的两个高斯分布就是针对两类数据各自进行的拟合。要注意这两个高斯分布的轮廓图有同样的形状和拉伸方向,这是因为他们都有同样的协方差矩阵$\Sigma$,但他们有不同的均值$\mu_0$ 和 $\mu_1$ 。此外,图中的直线给出了$p (y = 1|x) = 0.5$ 这条边界线。在这条边界的一侧,我们预测 $y = 1$是最可能的结果,而另一侧,就预测 $y = 0$是最可能的结果。

1.3 讨论:高斯判别分析(GDA)与逻辑回归(logistic regression)

高斯判别分析模型与逻辑回归有很有趣的相关性。如果我们把变量(quantity)$p (y = 1|x; \phi, \mu_0, \mu_1, \Sigma)$ 作为一个 $x$ 的函数,就会发现可以用如下的形式来表达:

$$

p(y=1|x;\phi,\Sigma,\mu_0,\mu_1)=\frac 1 {1+exp(-\theta^Tx)}

$$

其中的 $\theta$ 是对$\phi$, $\Sigma$, $\mu_0$, $\mu_1$的某种函数。这就是逻辑回归(也是一种判别分析算法)用来对$p (y = 1|x)$ 建模的形式。

注:上面这里用到了一种转换,就是重新对$x^{(i)}$向量进行了定义,在右手侧(right-hand-side)增加了一个额外的坐标$x_0^{(i)} = 1$,然后使之成为了一个 $n+1$维的向量;具体内容参考习题集1。

这两个模型中什么时候该选哪一个呢?一般来说,高斯判别分析(GDA)和逻辑回归,对同一个训练集,可能给出的判别曲线是不一样的。哪一个更好些呢?

我们刚刚已经表明,如果$p(x|y)$是一个多变量的高斯分布(且具有一个共享的协方差矩阵$\Sigma$),那么$p(y|x)$则必然符合一个逻辑函数(logistic function)。然而,反过来,这个命题是不成立的。例如假如$p(y|x)$是一个逻辑函数,这并不能保证$p(x|y)$一定是一个多变量的高斯分布。这就表明高斯判别模型能比逻辑回归对数据进行更强的建模和假设(stronger modeling assumptions)。 这也就意味着,在这两种模型假设都可用的时候,高斯判别分析法去拟合数据是更好的,是一个更好的模型。 尤其当$p(x|y)$已经确定是一个高斯分布(有共享的协方差矩阵$\Sigma$),那么高斯判别分析是渐进有效的(asymptotically efficient)。 实际上,这也意味着,在面对非常大的训练集(训练样本规模 $m $特别大)的时候,严格来说,可能就没有什么别的算法能比高斯判别分析更好(比如考虑到对 $p(y|x)$估计的准确度等等)。所以在这种情况下就表明,高斯判别分析(GDA)是一个比逻辑回归更好的算法;再扩展一下,即便对于小规模的训练集,我们最终也会发现高斯判别分析(GDA)是更好的。

奈何事有正反,由于逻辑回归做出的假设要明显更弱一些(significantly weaker),所以因此逻辑回归给出的判断鲁棒性(robust)也更强,同时也对错误的建模假设不那么敏感。有很多不同的假设集合都能够将$p(y|x)$引向逻辑回归函数。例如,如果$x|y = 0\sim Poisson(\lambda_0)$ 是一个泊松分布,而$x|y = 1\sim Poisson(\lambda_1)$也是一个泊松分布,那么$p(y|x)$也将是适合逻辑回归的(logistic)。逻辑回归也适用于这类的泊松分布的数据。但对这样的数据,如果我们强行使用高斯判别分析(GDA),然后用高斯分布来拟合这些非高斯数据,那么结果的可预测性就会降低,而且GDA这种方法也许可行,也有可能是不能用。

总结一下也就是:高斯判别分析方法(GDA)能够建立更强的模型假设,并且在数据利用上更加有效(比如说,需要更少的训练集就能有”还不错的”效果),当然前提是模型假设争取或者至少接近正确。逻辑回归建立的假设更弱,因此对于偏离的模型假设来说更加鲁棒(robust)。然而,如果训练集数据的确是非高斯分布的(non-Gaussian),而且是有限的大规模数据(in the limit of large datasets),那么逻辑回归几乎总是比GDA要更好的。因此,在实际中,逻辑回归的使用频率要比GDA高得多。(关于判别和生成模型的对比的相关讨论也适用于我们下面要讲的朴素贝叶斯算法(Naive Bayes),但朴素贝叶斯算法还是被认为是一个非常优秀也非常流行的分类算法。)

2 朴素贝叶斯法(Naive Bayes)

在高斯判别分析(GDA)方法中,特征向量 $x$ 是连续的,值为实数的向量。下面我们要讲的是当 $x_i$ 是离散值的时候来使用的另外一种学习算法。

下面就来继续看一个之前见过的样例,来尝试建立一个邮件筛选器,使用机器学习的方法。这回咱们要来对邮件信息进行分类,来判断是否为商业广告邮件(就是垃圾邮件),还是非垃圾邮件。在学会了怎么实现之后,我们就可以让邮件阅读器能够自动对垃圾信息进行过滤,或者单独把这些垃圾邮件放进一个单独的文件夹中。对邮件进行分类是一个案例,属于文本分类这一更广泛问题集合。

假设我们有了一个训练集(也就是一堆已经标好了是否为垃圾邮件的邮件)。要构建垃圾邮件分选器,咱们先要开始确定用来描述一封邮件的特征$x_i$有哪些。

我们将用一个特征向量来表示一封邮件,这个向量的长度等于字典中单词的个数。如果邮件中包含了字典中的第 $i$ 个单词,那么就令 $x_i = 1$;反之则$x_i = 0$。例如下面这个向量:

$$

x=\begin{bmatrix}1\0\0\\vdots \1\ \vdots \0\end{bmatrix} \begin{matrix}\text{a}\ \text{aardvark}\ \text{aardwolf}\ \vdots\ \text{buy}\ \vdots\ \text{zygmurgy}\ \end{matrix}

$$

就用来表示一个邮件,其中包含了两个单词 “a” 和 “buy”,但没有单词 “aardvark”, “aardwolf” 或者 “zymurgy” 。这个单词集合编码整理成的特征向量也成为词汇表(vocabulary,), 所以特征向量 $x$ 的维度就等于词汇表的长度。

注:实际应用中并不需要遍历整个英语词典来组成所有英语单词的列表,实践中更常用的方法是遍历一下训练集,然后把出现过一次以上的单词才编码成特征向量。这样做除了能够降低模型中单词表的长度之外,还能够降低运算量和空间占用,此外还有一个好处就是能够包含一些你的邮件中出现了而词典中没有的单词,比如本课程的缩写CS229。有时候(比如在作业里面),还要排除一些特别高频率的词汇,比如像冠词the,介词of 和and 等等;这些高频率但是没有具体意义的虚词也叫做stop words,因为很多文档中都要有这些词,用它们也基本不能用来判定一个邮件是否为垃圾邮件。

选好了特征向量了,接下来就是建立一个生成模型(generative model)。所以我们必须对$p(x|y)$进行建模。但是,假如我们的单词有五万个词,则特征向量$x \in {0, 1}^{50000}$ (即 $x$是一个 $50000$ 维的向量,其值是$0$或者$1$),如果我们要对这样的 $x$进行多项式分布的建模,那么就可能有$2^{50000}$ 种可能的输出,然后就要用一个 $(2^{50000}-1)$维的参数向量。这样参数明显太多了。

要给$p(x|y)$建模,先来做一个非常强的假设。我们假设特征向量$x_i$ 对于给定的 $y$ 是独立的。 这个假设也叫做朴素贝叶斯假设(Naive Bayes ,NB assumption), 基于此假设衍生的算法也就叫做朴素贝叶斯分类器(Naive Bayes classifier)。 例如,如果 $y = 1$ 意味着一个邮件是垃圾邮件;然后其中”buy” 是第$2087$个单词,而 “price”是第$39831$个单词;那么接下来我们就假设,如果我告诉你 $y = 1$,也就是说某一个特定的邮件是垃圾邮件,那么对于$x_{2087}$ (也就是单词 buy 是否出现在邮件里)的了解并不会影响你对$x_{39831}$ (单词price出现的位置)的采信值。更正规一点,可以写成 $p(x_{2087}|y) = p(x_{2087}|y, x_{39831})$。(要注意这个并不是说$x_{2087}$ 和 $x_{39831}$这两个特征是独立的,那样就变成了$p(x_{2087}) = p(x_{2087}|x_{39831})$,我们这里是说在给定了 $y$ 的这样一个条件下,二者才是有条件的独立。)

然后我们就得到了等式:

$$

\begin{aligned}

p(x_1, …, x_{50000}|y) & = p(x_1|y)p(x_2|y,x_1)p(x_3|y,x_1,x_2) … p(x_{50000}|y,x_1,x_2,…,x_{49999})\

& = p(x_1|y)p(x_2|y)p(x_3|y) … p(x_{50000}|y)\

& = \prod^n_{i=1}p(x_i|y)\

\end{aligned}

$$

第一行的等式就是简单地来自概率的基本性质,第二个等式则使用了朴素贝叶斯假设。这里要注意,朴素贝叶斯假设也是一个很强的假设,产生的这个算法可以适用于很多种问题。

我们这个模型的参数为 $\phi_{i|y=1} = p (x_i = 1|y = 1), \phi_{i|y=0} = p (x_i = 1|y = 0)$, 而 $\phi_y = p (y = 1)$。和以往一样,给定一个训练集${(x^{(i)},y^{(i)}); i = 1, …, m}$,就可以写出下面的联合似然函数:

$$

\mathcal{L}(\phi_y,\phi_{j|y=0},\phi_{j|y=1})=\prod^m_{i=1}p(x^{(i)},y^{(i)})

$$

找到使联合似然函数取得最大值的对应参数组合 $\phi_y , \phi_{i|y=0} 和 \phi_{i|y=1}$ 就给出了最大似然估计:

$$

\begin{aligned}

\phi_{j|y=1} &=\frac{\sum^m_{i=1}1{x_j^{(i)} =1 \wedge y^{(i)} =1} }{\sum^m_{i=1}1{y^{(i)} =1}} \

\phi_{j|y=0} &= \frac{\sum^m_{i=1}1{x_j^{(i)} =1 \wedge y^{(i)} =0} }{\sum^m_{i=1}1{y^{(i)} =0}} \

\phi_{y} &= \frac{\sum^m_{i=1}1{y^{(i)} =1}}{m}\

\end{aligned}

$$

在上面的等式中,”$\wedge$(and)”这个符号的意思是逻辑”和”。这些参数有一个非常自然的解释。例如 $\phi_{j|y=1}$ 正是垃圾 $(y = 1)$ 邮件中出现单词 $j$ 的邮件所占的比例。

拟合好了全部这些参数之后,要对一个新样本的特征向量 $x$ 进行预测,只要进行如下的简单地计算:

$$

\begin{aligned}

p(y=1|x)&= \frac{p(x|y=1)p(y=1)}{p(x)}\

&= \frac{(\prod^n_{i=1}p(x_i|y=1))p(y=1)}{(\prod^n_{i=1}p(x_i|y=1))p(y=1)+ (\prod^n_{i=1}p(x_i|y=0))p(y=0)} \

\end{aligned}

$$

然后选择有最高后验概率的概率。

最后我们要注意,刚刚我们对朴素贝叶斯算法的使用中,特征向量 $x_i$ 都是二值化的,其实特征向量也可以是多个离散值,比如${1, 2, …, k_i}$这样也都是可以的。这时候只需要把对$p(x_i|y)$ 的建模从伯努利分布改成多项式分布。实际上,即便一些原始的输入值是连续值(比如我们第一个案例中的房屋面积),也可以转换成一个小规模的离散值的集合,然后再使用朴素贝叶斯方法。例如,如果我们用特征向量 $x_i$ 来表示住房面积,那么就可以按照下面所示的方法来对这一变量进行离散化:

| 居住面积 | $<400$ | $400-800$ | $800-1200$ | $1200-1600$ | $>1600$ |

|---|---|---|---|---|---|

| 离散值 $x_i$ | $1$ | $2$ | $3$ | $4$ | $5$ |

这样,对于一个面积为 $890$ 平方英尺的房屋,就可以根据上面这个集合中对应的值来把特征向量的这一项的$x_i$值设置为$3$。然后就可以用朴素贝叶斯算法,并且将$p(x_i|y)$作为多项式分布来进行建模,就都跟前面讲过的内容一样了。当原生的连续值的属性不太容易用一个多元正态分布来进行建模的时候,将其特征向量离散化然后使用朴素贝叶斯法(NB)来替代高斯判别分析法(GDA),通常能形成一个更好的分类器。

2.1 拉普拉斯平滑(Laplace smoothing)

刚刚讲过的朴素贝叶斯算法能够解决很多问题了,但还能对这种方法进行一点小调整来进一步提高效果,尤其是应对文本分类的情况。我们来简要讨论一下一个算法当前状态的一个问题,然后在讲一下如何解决这个问题。

还是考虑垃圾邮件分类的过程,设想你学完了CS229的课程,然后做了很棒的研究项目,之后你决定在$2003$年$6$月译者注:作者这讲义一定写得很早把自己的作品投稿到NIPS会议,这个NIPS是机器学习领域的一个顶级会议,递交论文的截止日期一般是六月末到七月初。你通过邮件来对这个会议进行了讨论,然后你也开始收到带有 nips 四个字母的信息。但这个是你第一个NIPS论文,而在此之前,你从来没有接到过任何带有 nips 这个单词的邮件;尤其重要的是,nips 这个单词就从来都没有出现在你的垃圾/正常邮件训练集里面。假如这个 nips 是你字典中的第$35000$个单词,那么你的朴素贝叶斯垃圾邮件筛选器就要对参数$\phi_{35000|y}$ 进行最大似然估计,如下所示:

$$

\begin{aligned}

\phi_{35000|y=1} &= \frac{\sum^m_{i=1}1{x^{(i)}{35000}=1 \wedge y^{(i)}=1 }}{\sum^m{i=1}1{y^{(i)}=0}} &=0 \

\phi_{35000|y=0} &= \frac{\sum^m_{i=1}1{x^{(i)}{35000}=1 \wedge y^{(i)}=0 }}{\sum^m{i=1}1{y^{(i)}=0}} &=0 \

\end{aligned}

$$

也就是说,因为之前程序从来没有在别的垃圾邮件或者正常邮件的训练样本中看到过 nips 这个词,所以它就认为看到这个词出现在这两种邮件中的概率都是$0$。因此当要决定一个包含 nips 这个单词的邮件是否为垃圾邮件的时候,他就检验这个类的后验概率,然后得到了:

$$

\begin{aligned}

p(y=1|x) &= \frac{ \prod^n_{i=1} p(x_i|y=1)p(y=1) } {\prod^n_{i=1} p(x_i|y=1)p(y=1) +\prod^n_{i=1} p(x_i|y=0)p(y=0) }\

&= \frac00\

\end{aligned}

$$

这是因为对于” $\prod^n_{i=1} p(x_i|y)$”中包含了$p(x_{35000}|y) = 0$的都加了起来,也就还是$0$。所以我们的算法得到的就是 $\frac00$,也就是不知道该做出怎么样的预测了。

然后进一步拓展一下这个问题,统计学上来说,只因为你在自己以前的有限的训练数据集中没见到过一件事,就估计这个事件的概率为零,这明显不是个好主意。假设问题是估计一个多项式随机变量 $z$ ,其取值范围在${1,…, k}$之内。接下来就可以用$\phi_i = p (z = i)$ 来作为多项式参数。给定一个 $m$ 个独立观测${z^{(1)}, …, z^{(m)}}$ 组成的集合,然后最大似然估计的形式如下:

$$

\phi_j=\frac{\sum^m_{i=1}1{z^{(i)}=j}}m

$$

正如咱们之前见到的,如果我们用这些最大似然估计,那么一些$\phi_j$可能最终就是零了,这就是个问题了。要避免这个情况,咱们就可以引入拉普拉斯平滑(Laplace smoothing), 这种方法把上面的估计替换成:

$$

\phi_j=\frac{\sum^m_{i=1}1{z^{(i)}=j}+1}{m+k}

$$

这里首先是对分子加$1$,然后对分母加$k$,要注意$\sum^k_{j=1} \phi_j = 1$依然成立(自己检验一下),这是一个必须有的性质,因为$\phi_j$ 是对概率的估计,然后所有的概率加到一起必然等于$1$。另外对于所有的 $j$ 值,都有$\phi_j \neq 0$,这就解决了刚刚的概率估计为零的问题了。在某些特定的条件下(相当强的假设条件下,arguably quite strong),可以发现拉普拉斯平滑还真能给出对参数$\phi_j$ 的最佳估计(optimal estimator)。

回到我们的朴素贝叶斯分选器问题上,使用了拉普拉斯平滑之后,对参数的估计就写成了下面的形式:

$$

\begin{aligned}

\phi_{j|y=1} & =\frac{\sum^m_{i=1}1{x_j^{(i)}=1\wedge y ^{(i)}=1}+1}{\sum^m_{i=1}1{y^{(i)}=1}+2}\

\phi_{j|y=0} & =\frac{\sum^m_{i=1}1{x_j^{(i)}=1\wedge y ^{(i)}=0}+1}{\sum^m_{i=1}1{y^{(i)}=0}+2}\

\end{aligned}

$$

(在实际应用中,通常是否对$\phi_y$ 使用拉普拉斯并没有太大影响,因为通常我们会对每个垃圾邮件和非垃圾邮件都有一个合适的划分比例,所以$\phi_y$ 会是对$p(y = 1)$ 的一个合理估计,无论如何都会与零点有一定距离。)

2.2 针对文本分类的事件模型(Event models for text classification)

到这里就要给咱们关于生成学习算法的讨论进行一下收尾了,所以就接着讲一点关于文本分类方面的另一个模型。我们刚已经演示过的朴素贝叶斯方法能够解决很多分类问题了,不过还有另一个相关的算法,在针对文本的分类效果还要更好。

在针对文本进行分类的特定背景下,咱们上面讲的朴素贝叶斯方法使用的是一种叫做多元伯努利事件模型(Multi-Variate Bernoulli event model)。 在这个模型里面,我们假设邮件发送的方式,是随机确定的(根据先验类class priors, $p(y)$),无论是不是垃圾邮件发送者,他是否给你发下一封邮件都是随机决定的。那么发件人就会遍历词典,决定在邮件中是否包含某个单词 $i$,各个单词之间互相独立,并且服从概率分布$p(x_i=1|y)=\phi_{i|y}$。因此,一条消息的概率为:$p(y)\prod^n_{i-1}p(x_i|y)$

然后还有另外一个模型,叫做多项式事件模型(Multinomial event model)。 要描述这个模型,我们需要使用一个不同的记号和特征集来表征各种邮件。设 $x_i$ 表示单词中的第$i$个单词。因此,$x_i$现在就是一个整数,取值范围为${1,…,|V|}$,这里的$|V|$是词汇列表(即字典)的长度。这样一个有 $n$ 个单词的邮件就可以表征为一个长度为 $n$ 的向量$(x_1,x_2,…,x_n)$;这里要注意,不同的邮件内容,$n$ 的取值可以是不同的。例如,如果一个邮件的开头是”A NIPS . . .” ,那么$x_1 = 1$ (“a” 是词典中的第一个),而$x_2 = 35000$ (这是假设 “nips”是词典中的第35000个)。

在多项式事件模型中,我们假设邮件的生成是通过一个随机过程的,而是否为垃圾邮件是首先决定的(根据$p(y)$),这个和之前的模型假设一样。然后邮件的发送者写邮件首先是要生成 从对单词$(p(x_1|y))$ 的某种多项式分布中生成 $x_1$。然后第二步是独立于 $x_1$ 来生成 $x_2$,但也是从相同的多项式分布中来选取,然后是 $x_3$,$x_4$ 等等,以此类推,直到生成了整个邮件中的所有的词。因此,一个邮件的总体概率就是$p(y)\prod^n_{i=1}p(x_i|y)$。要注意这个方程看着和我们之前那个多元伯努利事件模型里面的邮件概率很相似,但实际上这里面的意义完全不同了。尤其是这里的$x_i|y$现在是一个多项式分布了,而不是伯努利分布了。

我们新模型的参数还是$\phi_y = p(y)$,这个跟以前一样,然后还有$\phi_{k|y=1} = p(x_j =k|y=1)$ (对任何 $j$)以及 $\phi_{i|y=0} =p(x_j =k|y=0)$。要注意这里我们已经假设了对于任何$j$ 的值,$p(x_j|y)$这个概率都是相等的,也就是意味着在这个哪个词汇生成的这个分布不依赖这个词在邮件中的位置$j$。

如果给定一个训练集${(x^{(i)},y^{(i)}); i = 1, …, m}$,其中 $x^{(i)} = ( x^{(i)}{1} , x^{(i)}{2} ,…, x^{(i)}_{n_i})$(这里的$n$是在第$i$个训练样本中的单词数目),那么这个数据的似然函数如下所示:

$$

\begin{aligned}

\mathcal{L}(\phi,\phi_{k|y=0},\phi_{k|y=1})& = \prod^m_{i=1}p( x^{(i)},y^{(i)})\

& = \prod^m_{i=1}(\prod^{n_i}{j=1}p(x_j^{(i)}|y;\phi{k|y=0},\phi_{k|y=1}))p( y^{(i)};\phi_y)\

\end{aligned}

$$

让上面的这个函数最大化就可以产生对参数的最大似然估计:

$$

\begin{aligned}

\phi_{k|y=1}&= \frac{\sum^m_{i=1}\sum^{n_i}{j=1}1{x_j^{(i)}=k\wedge y^{(i)}=1}}{\sum^m{i=1}1{y^{(i)}=1}n_i} \

\phi_{k|y=0}&= \frac{\sum^m_{i=1}\sum^{n_i}{j=1}1{x_j^{(i)}=k\wedge y^{(i)}=0}}{\sum^m{i=1}1{y^{(i)}=0}n_i} \

\phi_y&= \frac{\sum^m_{i=1}1{y^{(i)}=1}}{m}\

\end{aligned}

$$

如果使用拉普拉斯平滑(实践中会用这个方法来提高性能)来估计$\phi_{k|y=0}$ 和 $\phi_{k|y=1}$,就在分子上加1,然后分母上加$|V|$,就得到了下面的等式:

$$

\begin{aligned}

\phi_{k|y=1}&= \frac{\sum^m_{i=1}\sum^{n_i}{j=1}1{x_j^{(i)}=k\wedge y^{(i)}=1}+1}{\sum^m{i=1}1{y^{(i)}=1}n_i+|V|} \

\phi_{k|y=0}&= \frac{\sum^m_{i=1}\sum^{n_i}{j=1}1{x_j^{(i)}=k\wedge y^{(i)}=0}+1}{\sum^m{i=1}1{y^{(i)}=0}n_i+|V|} \

\end{aligned}

$$

当然了,这个并不见得就是一个最好的分类算法,不过朴素贝叶斯分选器通常用起来还都出乎意料地那么好。所以这个方法就是一个很好的”首发选择”,因为它很简单又很好实现。

第三章

第五部分 支持向量机(Support Vector Machines)

本章的讲义主要讲述的是 支持向量机(Support Vector Machine ,缩写为 SVM) 学习算法。SVM 算得上是现有的最好的现成的(“off-the-shelf”)监督学习算法之一,很多人实际上认为这里没有“之一”这两个字的必要,认为 SVM 就是最好的现成的监督学习算法。讲这个 SVM 的来龙去脉之前,我们需要先讲一些关于边界的内容,以及对数据进行分割成大的区块(gap)的思路。接下来,我们要讲一下最优边界分类器(optimal margin classifier,),其中还会引入一些关于拉格朗日对偶(Lagrange duality)的内容。然后我们还会接触到核(Kernels),这提供了一种在非常高的维度(例如无穷维度)中进行 SVM 学习的高效率方法,最终本章结尾部分会讲 SMO 算法,也就是 SVM 算法的一个有效实现方法。

1 边界(Margins):直觉(Intuition)

咱们这回讲 SVM 学习算法,从边界(margins)开始说起。这一节我们会给出关于边界的一些直观展示(intuitions),以及对于我们做出的预测的信心(confidence);在本章的第三节中,会对这些概念进行更正式化的表述。

考虑逻辑回归,其中的概率分布$p(y = 1|x;\theta)$ 是基于 $h_\theta(x) = g(\theta^Tx)$ 而建立的模型。当且仅当 $h_\theta(x) \geq 0.5$ ,也就是 $\theta^Tx \geq 0$ 的时候,我们才会预测出“$1$”。假如有一个正向(Positive)的训练样本(positive tra_ining example)($y = 1$)。那么$\theta^Tx$ 越大,$h_\theta (x) = p(y = 1|x; w, b)$ 也就越大,我们对预测 Label 为 $1$ 的“信心(confidence)”也就越强。所以如果 $y = 1$ 且 $\theta^T x \gg 0$(远大于 $0$),那么我们就对这时候进行的预测非常有信心,当然这只是一种很不正式的粗略认识。与之类似,在逻辑回归中,如果有 $y = 0$ 且 $\theta^T x \ll 0$(远小于 0),我们也对这时候给出的预测很有信心。所以还是以一种非常不正式的方式来说,对于一个给定的训练集,如果我们能找到一个 $\theta$,满足当 $y^{(i)} = 1$ 的时候总有 $\theta^T x^{(i)} \gg 0$,而 $y^{(i)} = 0$ 的时候则 $\theta^T x^{(i)} \ll 0$,我们就说这个对训练数据的拟合很好,因为这就能对所有训练样本给出可靠(甚至正确)的分类。似乎这样就是咱们要实现的目标了,稍后我们就要使用函数边界记号(notion of functional margins) 来用正规的语言来表达该思路。

还有另外一种的直观表示,例如下面这个图当中,画叉的点表示的是正向训练样本,而小圆圈的点表示的是负向训练样本,图中还画出了分类边界(decision boundary), 这条线也就是通过等式 $\theta^T x = 0$ 来确定的,也叫做分类超平面(separating hyperplane)。 图中还标出了三个点 $A,B 和 C$。

可以发现 $A$ 点距离分界线很远。如果我们对 $A$ 点的 $y$ 值进行预测,估计我们会很有信心地认为在那个位置的 $y = 1$。与之相反的是 $C$,这个点距离边界线很近,而且虽然这个 $C$ 点也在预测值 $y = 1$ 的一侧,但看上去距离边界线的距离实在是很近的,所以也很可能会让我们对这个点的预测为 $y = 0$。因此,我们对 $A$ 点的预测要比对 $C$ 点的预测更有把握得多。$B$ 点正好在上面两种极端情况之间,更广泛地说,如果一个点距离分类超平面(separating hyperplane) 比较远,我们就可以对给出的预测很有信心。那么给定一个训练集,如果我们能够找到一个分类边界,利用这个边界我们可以对所有的训练样本给出正确并且有信心(也就是数据点距离分类边界要都很远)的预测,那这就是我们想要达到的状态了。当然上面这种说法还是很不正规,后面我们会使用几何边界记号(notion of geometric margins) 来更正规地来表达。

2 记号(Notation)

在讨论 SVMs 的时候,出于简化的目的,我们先要引入一个新的记号,用来表示分类。假设我们要针对一个二值化分类的问题建立一个线性分类器,其中用来分类的标签(label)为 $y$,分类特征(feature)为 $x$。从此以后我们就用 $y \in <!–swig0–>

$$

现在,我们假设这个联合收敛成立(uniform convergence holds),也就是说,对于所有的 $h \in H$,都有 $|ε(h)-\hat\epsilon(h)| ≤ \gamma$。我们的学习算法选择了 $\hat{h} = arg\min_{h\in H} \hat\epsilon(h)$,关于这种算法的泛化,我们能给出什么相关的证明呢?

将 $h^∗ = arg \min_{h\in H} \epsilon(h)$ 定义为 $H$ 中最佳可能假设(best possible hypothesis)。这里要注意此处的 $h^∗$ 是我们使用假设集合 $H$ 所能找出的最佳假设,所以很自然地,我们就能理解可以用这个 $h^∗$ 来进行性能对比了。则有:

$$

\begin{aligned}

\epsilon(\hat h) & \le \hat\epsilon(\hat h)+\gamma \

& \le \hat\epsilon(h^*)+\gamma \

& \le \epsilon(h^*)+2\gamma

\end{aligned}

$$

上面的第一行用到了定理 $| \epsilon(\hat h) - \hat\epsilon (\hat h) | \le \gamma$(可以通过上面的联合收敛假设来推出)。第二行用到的定理是 $\hat{h}$ 是选来用于得到最小 $\hat\epsilon(h)$ ,然后因此对于所有的 $h$ 都有 $\hat\epsilon(\hat{h}) \leq \hat\epsilon(h)$,也就自然能推出 $\hat\epsilon(\hat{h}) \le \hat\epsilon(h^∗)$ 。第三行再次用到了上面的联合收敛假设,此假设表明 $\hat\epsilon(h^∗) \le \epsilon(h^∗) + \gamma$ 。所以,我们就能得出下面这样的结论:如果联合收敛成立,那么 $\hat h$ 的泛化误差最多也就与 $H$ 中的最佳可能假设相差 $2\gamma$。

好了,咱们接下来就把上面这一大堆整理成一条定理(theorem)。

定理: 设 $|H| = k$译者注:即 H 集合中元素个数为 k,然后设 $m$ 和 $\delta$ 为任意的固定值。然后概率至少为 $1 - \delta$,则有:

$$

\epsilon(\hat h)\le (\min_{h\in H}\epsilon(h))+2\sqrt{\frac{1}{2m}log\frac{2k}{\delta}}

$$

上面这个的证明,可以通过令 $\gamma$ 等于平方根$\sqrt{\cdot}$的形式,然后利用我们之前得到的概率至少为 $1 – \delta$ 的情况下联合收敛成立,接下来利用联合收敛能表明 $\epsilon(h)$ 最多比 $\epsilon(h^∗) = \min_{h\in H} \epsilon(h)$ 多 $2\gamma$(这个前面我们已经证明过了)。

这也对我们之前提到过的在模型选择的过程中在偏差(bias)/方差(variance)之间的权衡给出了定量方式。例如,加入我们有某个假设类 $H$,然后考虑切换成某个更大规模的假设类 $H’ \supseteq H$。如果我们切换到了 $H’$ ,那么第一次的 $\min_h \epsilon(h)$ 只可能降低(因为我们这次在一个更大规模的函数集合里面来选取最小值了)。因此,使用一个更大规模的假设类来进行学习,我们的学习算法的“偏差(bias)”只会降低。然而,如果 $k$ 值增大了,那么第二项的那个二倍平方根项$2\sqrt{\cdot}$也会增大。这一项的增大就会导致我们使用一个更大规模的假设的时候,“方差(variance)”就会增大。

通过保持 $\gamma$ 和 $\delta$ 为固定值,然后像上面一样求解 $m$,我们还能够得到下面的样本复杂度约束:

推论(Corollary): 设 $|H| = k$ ,然后令 $\delta,\gamma$ 为任意的固定值。对于满足概率最少为 $1 - \delta$ 的 $\epsilon(\hat{h}) \le min_{h\in H} \epsilon(h) + 2\gamma$ ,下面等式关系成立:

$$

\begin{aligned}

m &\ge \frac{1}{2\gamma^2}log\frac{2k}{\delta} \

& = O(\frac{1}{\gamma^2}log\frac{k}{\delta})

\end{aligned}

$$

4 无限个假设(infinite H)的情况

我们已经针对有限个假设类的情况证明了一些有用的定理。然而有很多的假设类都包含有无限个函数,其中包括用实数参数化的类(比如线性分类问题)。那针对这种无限个假设的情况,我们能证明出类似的结论么?

我们先从一些不太“准确”论证的内容开始(not the “right” argument)。当然也有更好的更通用的论证,但先从这种不太“准确”的内容除法,将有助于锻炼我们在此领域内的直觉(intuitions about the domain)。

若我们有一个假设集合 $H$,使用 $d$ 个实数来进行参数化(parameterized by d real numbers)。由于我们使用计算机表述实数,而 IEEE 的双精度浮点数( C 语言里面的 double 类型)使用了 64 bit 来表示一个浮点数(floating-point number,),这就意味着如果我们在学习算法中使用双精度浮点数(double- precision floating point),那我们的算法就由 64 d 个 bit 来进行参数化(parameterized by 64d bits)。这样我们的这个假设类实际上包含的不同假设的个数最多为 $k = 2^{64d}$ 。结合上一节的最后一段那个推论(Corollary),我们就能发现,要保证 $\epsilon(\hat{h}) \leq \epsilon(h^∗) + 2\gamma$ ,同时还要保证概率至少为 $1 - \delta$ ,则需要训练样本规模 $m$ 满足$m \ge O(\frac{1}{\gamma^2}log\frac{2^{64d}}{\delta})=O(\frac{d}{\gamma^2}log\frac{1}{\delta})=O_{\gamma,\delta}(d)$(这里的 $\gamma$,$\delta$下标表示最后一个大$O$可能是一个依赖于$\gamma$和$\delta$的隐藏常数。)因此,所需的训练样本规模在模型参数中最多也就是线性的(the number of training examples needed is at most linear in the parameters of the model)。

The fact that we relied on 64-bit floating point makes this argument not entirely satisfying, but the conclusion is nonetheless roughly correct: If what we’re going to do is try to minimize training error, then in order to learn “well” using a hypothesis class that has d parameters, generally we’re going to need on the order of a linear number of training examples in d.

上述论证依赖于假定参数是 64 位浮点数(但是实际上实数参数不一定如此实现),因此还不能完全令人满意,但这个结论大致上是正确的:如果我们试图使训练误差(training error)最小化,那么为了使用具有 $d$ 个参数的假设类(hypothesis class)的学习效果“较好(well)”,通常就需要 $d$ 的线性规模个训练样本。

(在这里要注意的是,对于使用经验风险最小化(empirical risk minimization ,ERM)的学习算法,上面这些结论已经被证明适用。因此,样本复杂度(sample complexity)对 $d$ 的线性依赖性通常适用于大多数分类识别学习算法(discriminative learning algorithms),但训练误差或者训练误差近似值的最小化,就未必适用于分类识别了。对很多的非 ERM 学习算法提供可靠的理论论证,仍然是目前很活跃的一个研究领域。)

前面的论证还有另外一部分让人不太满意,就是依赖于对 $H$ 的参数化(parameterization)。根据直觉来看,这个参数化似乎应该不会有太大影响:我们已经把线性分类器(linear classifiers)写成了 $h_\theta(x) = 1{\theta_0 + \theta_1x_1 + ···\theta_n x_n \geq 0}$ 的形式,其中有 $n+1$ 个参数 $\theta_0,…,\theta_n$ 。但也可以写成 $h_{u,v}(x) = 1{(u^2_0 - v_0^2) + (u^2_1 - v_1^2)x1 + ··· (u^2_n - v_n^2)x_n \geq 0}$ 的形式,这样就有 $2n+2$ 个参数 $u_i, v_i$ 了。然而这两种形式都定义了同样的一个 $H:$ 一个 $n$ 维的线性分类器集合。

要推导出更让人满意的论证结果,我们需要再额外定义一些概念。

给定一个点的集合 $S = {x^{(i)}, …, x^{(d)}}$(与训练样本集合无关),其中 $x(i) \in X$,如果 $H$ 能够对 集合 $S$ 实现任意的标签化(can realize any labeling on S),则称 $H$ 打散(shatter) 了 $S$。例如,对于任意的标签集合 (set of labels)${y^{(1)}, …, y^{(d)}}$,都有 一些$h\in H$ ,对于所有的$i = 1, …d$,式子$h(x^{(i)}) = y^{(i)}$都成立。(译者注:关于 shattered set 的定义可以参考:https://en.wikipedia.org/wiki/Shattered_set 更多关于 VC 维 的内容也可以参考:https://www.zhihu.com/question/38607822 )

给定一个假设类 $H$,我们定义其 VC维度(Vapnik-Chervonenkis dimension), 写作 $VC(H)$,这个值也就是能被 $H$ 打散(shatter)的最大的集合规模。(如果 $H$ 能打散任意大的集合(arbitrarily large sets),那么 $VC(H) = ∞$。)

例如,若一个集合由下图所示的三个点组成:

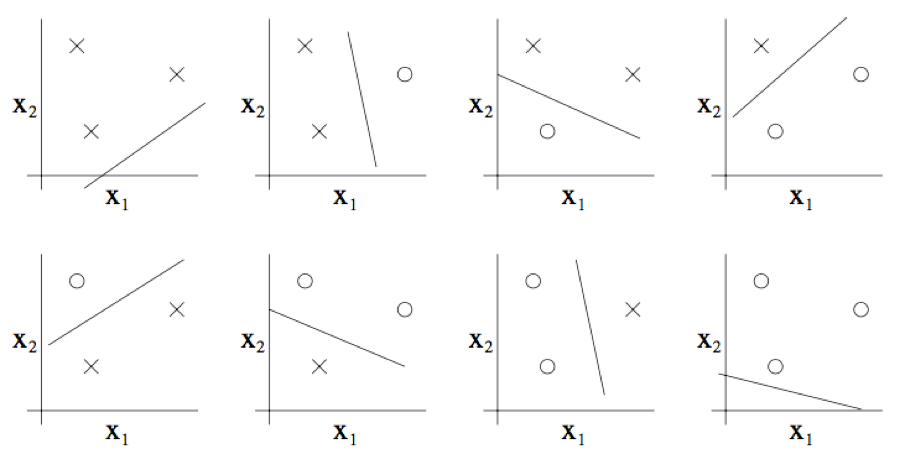

那么二维线性分类器 $(h(x) = 1{\theta_0 +\theta_1 x_1 + \theta_2 x_2 \geq 0})$ 的集合 $H$ 能否将上图所示的这个集合打散呢?答案是能。具体来看则如下图所示,以下八种分类情况中的任意一个,我们都能找到一种用能够实现 “零训练误差(zero training error)” 的线性分类器(linear classifier):

此外,这也有可能表明,这个假设类 $H$ 不能打散(shatter)4 个点构成的集合。因此,$H$ 可以打散(shatter)的最大集合规模为 3,也就是说 $VC(H)= 3$。

这里要注意,$H$ 的 $VC$ 维 为3,即便有某些 3 个点的集合不能被 $H$ 打散。例如如果三个点都在一条直线上(如下图左侧的图所示),那就没办法能够用线性分类器来对这三个点的类别进行划分了(如下图右侧所示)。

换个方式来说,在 $VC$ 维 的定义之下,要保证 $VC(H)$ 至少为 $d$,只需要证明至少有一个规模为 $d$ 的集合能够被 $H$ 打散 就可以了。

这样就能够给出下面的定理(theorem)了,该定理来自 Vapnik。(有不少人认为这是所有学习理论中最重要的一个定理。)

Theorem. Let H be given, and let d = VC(H). Then with probability at least 1-δ, we have that for all h∈H,

定理:给定 $H$,设 $d = VC(H)$。然后对于所有的 $h\in H$,都有至少为 $1-\delta$ 的概率使下面的关系成立:

$$

|\epsilon(h)-\hat\epsilon(h)|\le O(\sqrt{\frac{d}{m}log\frac{d}{m}+\frac 1mlog\frac 1\delta})

$$

此外,有至少为 $1-\delta$ 的概率:

$$

\epsilon(\hat h)\le \epsilon(h^*)+O(\sqrt{\frac{d}{m}log\frac{d}{m}+\frac 1mlog\frac 1\delta})

$$

换句话说,如果一个假设类有有限的 $VC$ 维,那么只要训练样本规模 $m$ 增大,就能够保证联合收敛成立(uniform convergence occurs)。和之前一样,这就能够让我们以 $\epsilon(h)$ 的形式来给 $\epsilon(h^∗)$ 建立一个约束(bound)。此外还有下面的推论(corollary):

Corollary. For $|ε(h) - \hat\epsilon(h)| ≤ \gamma$ to hold for all h ∈ H (and hence $\epsilon(\hat{h}) ≤ \epsilon(h^∗) + 2\gamma$) with probability at least 1 - δ, it suffices that $m = O_{\gamma,\delta}(d)$.

推论(Corollary): 对于所有的 $h \in H$ 成立的 $|\epsilon(h) - \epsilon(\hat h)| \le \gamma$ (因此也有 $\epsilon(\hat h) ≤ \epsilon(h^∗) + 2\gamma$),则有至少为 $1 – \delta$ 的概率,满足 $m = O_{\gamma,\delta}(d)$。

In other words, the number of training examples needed to learn “well” using H is linear in the VC dimension of H. It turns out that, for “most” hypothesis classes, the VC dimension (assuming a “reasonable” parameterization) is also roughly linear in the number of parameters. Putting these together, we conclude that (for an algorithm that tries to minimize training error) the number of training examples needed is usually roughly linear in the number of parameters of H.

换个方式来说,要保证使用 假设集合 $H$ 的 机器学习的算法的学习效果“良好(well)”,那么训练集样本规模 $m$ 需要与 $H$ 的 $VC$ 维度 线性相关(linear in the VC dimension of H)。这也表明,对于“绝大多数(most)”假设类来说,(假设是“合理(reasonable)”参数化的)$VC$ 维度也大概会和参数的个数线性相关。把这些综合到一起,我们就能得出这样的一个结论:对于一个试图将训练误差最小化的学习算法来说:训练样本个数 通常都大概与假设类 $H$ 的参数个数 线性相关。

第五章

第七部分 正则化与模型选择

设想一个机器学习的问题,我们要从一系列不同的模型中进行挑选。例如,我们可能是用一个多项式回归模型 (polynomial regression model) $h_\theta (x)=g(\theta_0+\theta_1x+\theta_2x^2+\cdots+\theta_kx^k)$ 想要判定这里的多项式次数 $k$ 应该是多少,$0, 1, …, 或者10$。那么我们怎么才能自动选择一个能够在偏差 (bias)/方差(variance)$^1$之间进行权衡的模型呢? 或者换一个说法,假如我们希望能够自动选出来一个带宽参数 (bandwidth parameter) $\tau$ 来用于局部加权回归(locally weighted regression,所谓为 LWR,参考 note1的第2节),或 者要自动选出一个参数 $C$ 用于拉格朗日正则化的支持向量机算法(l1-regularized SVM)。怎么来实现呢?

1 考虑到前面的讲义中我们已经提到过偏差(bias)/方差(variance)这两个概念很大区别,有的读者可能觉得是不是应该把它们叫做一对“孪生 (twin)”魔鬼(evils)。或许可以把它们俩当做是一对异卵双胞胎(non-identical twins)。理解概念差别就好了,怎么说什么的都不要紧的。

为了具体一些,咱们这一系列讲义中都假设备选集合的模型个数有限 $M = {M_1,\cdots,M_d}$。例如,在我们上面刚刚随便举的本章第一个例子中,$M_i$ 就是一个 $i$次多项式拟合模型(i-th order polynomial regression model)。(其实把 $M$ 扩展到无穷集合 也不难的。$^2$)换个说法就是,如果我们要从支持向量机算法 (SVM)、神经网络算法(neural network)、逻辑回归算法(logistic regression)当中三选一,那么这里的 $M$ 就应该都 包含了这些模型了。

2 如果我们要从一个无穷的模型集合中进行选取一个,假如说要选取一个带宽参数 $\tau\in \mathbb R^+$ (正实数)的某个可能的值,可以将 $\tau$ 离散化,而只考虑 有限的一系列值。更广泛来说,我们要讲到的大部分算法都可以看做在模型空间(space of models) 中进行优化搜索 (performing optimization search)的 问题,这种搜索也可以在无穷模型类(infinite model classes)上进行。

1 交叉验证(Cross Validation)

假如我们得到了一个训练集 $S$。我们已经了解了经验风险最小化(empirical risk minimization,缩写为 ERM),那么接下来就要通过使用 ERM 来进行模型选择来推导出一种新的算法:

- 对训练集 $S$ 中的每一个模型 (model) $M_i$ 进行训练,得到某假设类 (hypothesis) $h_i$

- 从这些假设中选取训练误差最小的假设 (hypothesis)

上面这个算法是行不通的。比如考虑要选择多项式的阶(最高次项的次数)的情况。多项式的阶越高,对训练集 $S$ 的拟合程度就越好,训练误差自然也就更小。然而,这个方法选出来 的总是那种波动非常强 (high-variance) 的高次多项式模型 (high-degree polynomial model) ,这种情况我们之前就讲过了,通常都是很差的选择。

下面这个算法就更好一些。这个方法叫保留交叉验证 (hold-out cross validation),也叫简单交叉验证 (simple cross validation),步骤如下:

- 随机拆分训练集 $S$ 成 $S_{train}$ (例如,可以选择整体数据中 的 70% 用于训练) 和 $S_{cv}$ (训练集中剩余的 30%用于验 证)。这里的 $S_{cv}$ 就叫做保留交叉验证集(hold-out cross validation set)。

- 只对集合 $S_{train}$ 中的每一个模型 $M_i$ 进行训练,然后得到假设类(hypothesis) $h_i$。

- 筛选并输出对保留交叉验证集有最小误差 $\hat\epsilon_{S_{cv}}(h_i)$ 的假设$h_i$ 。(回忆一下,这里的 $\hat\epsilon_{S_{cv}}(h_i)$ 表示的是假设 $h$ 在保留交叉验证集 $S_{cv}$ 中的样本的经验误差(empirical error)。)

这样通过在一部分未进行训练的样本集合 $S_{cv}$ 上进行测试, 我们对每个假设 $h_i$ 的真实泛化误差 (generalization error) 就能得到一个比上一个方法更好的估计,然后就能选择出来一个有最小估计泛化误差 (smallest estimated generalization error) 的假设了。通常可以选择 1/4 到 1/3 的数据样本用来作为保留交叉验证集(hold out cross validation set),30% 是一个很典型的选择。

还有另外一种备选方法,就是在第三步的时候,也可以换做选 择与最小估计经验误差 $\hat\epsilon_{S_{cv}}(h_i)$ 对应的模型 $M_i$ ,然后对整 个训练样本数据集 $S$ 使用 $M_i$ 来进行再次训练。(这个思路通常都不错,但有一种情景例外,就是学习算法对初始条件和数据的扰动(perturbations of the initial conditions and/or data) 非常敏感的情况。在这样的方法中,适用于 $S_{train}$ 的模型未必就能够同样适用于 $S_{cv}$,这样就最好还是放弃再训练的步骤 (forgo this retraining step)。)

使用保留交叉验证集(hold out cross validation set)的一个弊端就是“浪费(waste)”了训练样本数据集的 30% 左右。甚至即便我们使用了备选的那个针对整个训练集使用模型进行 重新训练的步骤,也还不成,因为这无非是相当于我们只尝试在一个 $0.7m$ 规模的训练样本集上试图寻找一个好的模型来解决一个机器学习问题,而并不是使用了全部的 $m$ 个训练样 本,因为我们进行测试的都是每次在仅 $0.7m$ 规模样本上进 行训练而得到的模型。当然了,如果数据非常充足,或者是很廉价的话,也可以用这种方法,而如果训练样本数据本身就很 稀缺的话(例如说只有 20 个样本),那就最好用其他方法了。

下面就是一种这样的方法,名字叫 k-折交叉验证(k-fold cross validation),这样每次的用于验证的保留数据规模都更小:

随机将训练集 $S$ 切分成 $k$ 个不相交的子集。其中每一个子集的规模为 $m/k$ 个训练样本。这些子集为 $S_1,\cdots,S_k$

对每个模型 $M_i$,我们都按照下面的步骤进行评估(evaluate):

对 $j=1,\cdots,k$

在 $S_1\cup\cdots\cup S_{j-1}\cup S_{j+1}\cup\cdots\cup S_k$ (也就是除了 $S_j$ 之外的其他数据),对模型 $M_i$ 得到假设 $h_{ij}$ 。接下来针对 $S_j$ 使用假设 $h_{ij}$ 进行测试,得到经验误差 $\hat\epsilon_{S_{cv}}(h_{ij})$

对$\hat\epsilon_{S_{cv}}(h_{ij})$ 取平均值,计算得到的值就当作是模型 $M_i$ 的估计泛化误差(estimated generalization error)

选择具有最小估计泛化误差(lowest estimated generalization error)的模型 $M_i$ 的,然后在整个训练样本集 $S$ 上重新训练该模型。这样得到的假设 (hypothesis)就可以输出作为最终结果了。

通常这里进行折叠的次数 (number of folds) $k$ 一般是 10,即 $k = 10$。这样每次进行保留用于验证的数据块就只有 $1/k$ ,这 就比之前的 30% 要小多了,当然这样一来这个过程也要比简单的保留交叉验证方法消耗更多算力成本,因为现在需要对每个模型都进行 $k$ 次训练。

虽然通常选择都是设置 $k = 10$,不过如果一些问题中数据量 确实很匮乏,那有时候也可以走一点极端,设 $k = m$,这样是为了每次能够尽可能多地利用数据,尽可能少地排除数据。这 种情况下,我们需要在训练样本集 $S$ 中除了某一个样本外的其他所有样本上进行训练,然后在保留出来的单独样本上进行检验。然后把计算出来的 $m = k$ 个误差放到一起求平均值, 这样就得到了对一个模型的泛化误差的估计。这个方法有专门的名字,由于每次都保留了一个训练样本,所以这个方法就叫做弃一法交叉验证(leave-one-out cross validation)。

最后总结一下,咱们讲了不同版本的交叉验证,在上文中是用来作为选择模型的方法,实际上也可以更单纯地用来对一个具体的模型或者算法进行评估。例如,如果你已经实现了某中学习算法,然后想要估计一下针对你的用途这个算法的性能表现 (或者是你创造了一种新的学习算法,然后希望在技术论文中 报告你的算法在不同测试集上的表现),交叉验证都是个很好 的解决方法。

2 特征选择(Feature Selection)

模型选择(model selection)的一个非常重要的特殊情况就是特征选择(feature selection)。设想你面对一个监督学习问题 (supervised learning problem),其中特征值的数量 $n$ 特别大 (甚至可能比训练样本集规模还大,即$n >> m$),然而你怀疑可能只有一小部分的特征 (features) 是与学习任务“相关 (relevant)”的。甚至即便是针对 $n$ 个输入特征值使用一个简单的线性分类器 (linear classifier,例如感知器 perceptron),你的假设类(hypothesis class)的 $VC$ 维(VC dimension) 也依然能达到 $O(n)$,因此有过拟合 (overfitting) 的潜在风险,除非训练样本集也足够巨大 (fairly large)。

在这样的一个背景下,你就可以使用一个特征选择算法,来降 低特征值的数目。假设有 $n$ 个特征,那么就有 $2^n$ 种可能的特征子集 (因为 $n$ 个特征中的任意一个都可以被某个特征子集(feature subsets)包含或者排除),因此特征选择(feature selection)就可以看做是一个对 $2^n$ 种可能的模型进行选择 (model selection problem)的形式。对于特别大的 $n$,要是彻底枚举(enumerate)和对比全部 $2^n$ 种模型,成本就太高了, 所以通常的做法都是使用某些启发式的搜索过程(heuristic search procedure)来找到一个好的特征子集。下面的搜索过程叫做向前搜索(forward search) :

初始化一个集合为空集 $\mathcal F=\emptyset$

循环下面的过程{

(a) 对于 $i=1,\cdots,n$ 如果 $i\notin \mathcal F$,则令 $\mathcal F_i=\mathcal F\cup {i}$,然后使用某种交叉验证来评估特征 $\mathcal F_i$

(b) 令 $\mathcal F$ 为(a)中最佳特征子集

}

整个搜索过程中筛选出来了最佳特征子集(best feature subset),将其输出。

算法的外层循环可以在 $\mathcal F={1,\cdots,n}$ 达到全部特征规模时停止,也可以在 $|\mathcal F|$ 超过某个预先设定的阈值时停止(阈值和你想要算法用到特征数量最大值有关)。

这个算法描述的是对模型特征选择进行包装(包装器特征选择,Wrapper feature selection )的一个实例,此算法本身就是一个将学习算法进行“打包(wraps)”的过程,然后重复调用这个学习算法来评估(evaluate)此算法对不同的特征子集(feature subsets)的处理效果。除了向前搜索外,还可以使用其他的搜索过程。例如,可以**逆向搜索(backward search)**,从$\mathcal F = {1, …, n}$ ,即规模等同于全部特征开始,然后重复,每次删减一个特征,直到 $\mathcal F$ 为空集时终止。

这种包装器特征选择算法(Wrapper feature selection algorithms)通常效果不错,不过对算力开销也很大,尤其是要对学习算法进行多次调用。实际上,完整的向前搜索 (forward search,也就是 $\mathcal F$ 从空集开始,到最终达到整个样本集规模,即 $\mathcal F ={1, …, n}$ 终止)将要对学习算法调用约 $O(n^2)$ 次。

过滤器特征选择(Filter feature selection methods) 给出的特征子集选择方法更具有启发性(heuristic),而且在算力上的开销成本也更低。这里的一个思路是,计算一个简单的分数 $S(i)$,用来衡量每个特征 $x_i$ 对分类标签(class labels) $y$ 所能体现的信息量。然后,只需根据需要选择最大分数 $S(i)$ 的 $k$ 个特征。

怎么去定义用于衡量信息量的分值 $S(i)$ 呢?一种思路是使用 $x_i$ 和 $y$ 之间的相关系数的值(或其绝对值),这可以在训练 样本数据中算出。这样我们选出的就是与分类标签(class labels)的关系最密切的特征值(features)。实践中,通常(尤其当特征 $x_i$ 为离散值(discrete-valued features))选择 $x_i$ 和 $y$ 的互信息( mutual information, ${\rm{MI}}(x_i, y)$ ) 来作为 $S(i)$ 。

$$

{\rm{MI}}(x_i, y)=\sum_{x_i\in{0, 1}}\sum_{y\in{0,1}}p(x_i,y)\log\frac{p(x_i,y)}{p(x_i)p(y)}

$$

(上面这个等式假设了 $x_i$ 和 $y$ 都是二值化;更广泛的情况下将会超过变量的范围 。)上式中的概率$p(x_i,y)$,$p(x_i)$ 和 $p(y)$ 都可以根据它们在训练集上的经验分布(empirical distributions)而推测(estimated)得到。

要对这个信息量分值的作用有一个更直观的印象,也可以将互信息(mutual information)表达成 $KL$ 散度(Kullback-Leibler divergence,也称 $KL$ 距离,常用来衡量两个概率分布的距离):

$$

{\rm{MI}}(x_i,y)={\rm KL}(p(x_i,y),|,p(x_i)p(y))

$$

在下一节当中,你会与 $KL$ 散度进行更多的接触,这里比较通俗地说,这个概念对 $p(x_i,y)$ 和 $p(x_i)p(y)$ 的概率分布的差异程度给出一个衡量。如果 $x_i$ 和 $y$ 是两个独立的随机变量,那么必然有 $p(x_i, y) = p(x_i)p(y)$,而两个分布之间的 $KL$ 散度就应该是 $0$。这也符合下面这种很自然的认识:如果 $x_i$ 和 $y$ 相互独立,那么 $x_i$ 很明显对 $y$ 是“完全无信息量”(non-informative),因此对应的信息量分值 $S(i)$ 就应该很小。与之相反地,如果 $x_i$ 对 $y$ “有很大的信息量 (informative)”,那么这两者的互信息 ${\rm MI}(x_i,y)$ 就应该很大。

最后一个细节:现在你已经根据信息量分值 $S(i)$ 的高低来对特征组合(features)进行了排序,那么要如何选择特征个数 $k$ 呢?一个标准办法就是使用交叉验证(cross validation)来从可能的不同 $k$ 值中进行筛选。例如,在对文本分类(text classification)使用朴素贝叶斯方法(naive Bayes),这个问题中的词汇规模(vocabulary size) $n$ 通常都会特别大,使用 交叉验证的方法来选择特征子集(feature subset),一般都 提高分类器精度。

3 贝叶斯统计(Bayesianstatistics)和正则化 (regularization)

在本章,我们要讲一下另一种工具,用于我们对抗过拟合(overfitting)。

在本章的开头部分,我们谈到了使用最大似然(maximum likelihood,缩写为 ML)来进行参数拟合,然后根据下面的式子来选择参数:

$$

\theta_{\rm ML}=\arg \max_{\theta}\prod_{i=1}^{m}p(y^{(i)}|x^{(i)};\theta)

$$

在后续的讨论中,我们都是把 $\theta$ 看作是一个未知参数 (unknown parameter)。在频率统计(frequentist statistics) 中,往往采用的观点是认为 $\theta$ 是一个未知的常量(constant- valued)。在频率论(frequentist)的世界观中, $\theta$ 只是碰巧未知,而不是随机的,而我们的任务就是要找出某种统计过程 (statistical procedures,例如最大似然法(maximum likelihood)),来对这些参数进行估计。

另外一种解决我们这个参数估计问题的方法是使用贝叶斯世界观,把 $\theta$ 当做是未知的随机变量。在这个方法中,我们要先指定一个在 $\theta$ 上的先验分布(prior distribution) $p(\theta)$,这个 分布表达了我们关于参数的“预先判断(prior beliefs)”。给定一个训练集合 $S = {(x^{(i)},y^{(i)})}^m_{i=1}$,当我们被要求对一个新的 $x$ 的值进行预测的时候,我们可以计算在参数上的后验分布 (posterior distribution):

$$

\begin{aligned}

p(\theta|S)

&=\frac{p(S|\theta)p(\theta)}{p(S)}\

&=\frac{(\prod_{i=1}^{m}p(y^{(i)}|x^{(i)},\theta))p(\theta)}{\int_{\theta} {\left(\prod_{i=1}^{m}p(y^{(i)}|x^{(i)},\theta)p(\theta)\right)}d\theta}\qquad (1)

\end{aligned}

$$

在上面的等式中,$p(y(i)|x(i),\theta)$ 来自你所用的机器学习问题中的模型。例如,如果你使用贝叶斯逻辑回归(Bayesian logistic regression),你可能就会选择 $p(y^{(i)}|x^{(i)},\theta)=h_\theta(x^{(i)})^{y^{(i)}} (1-h_\theta(x^{(i)}))^{(1-y^{(i)})}$ 其中,$h_\theta(x^{(i)})=1/(1+\exp(-\theta^Tx^{(i)}))$.$^3$

3 由于我们在这里把 $\theta$ 看作是一个随机变量了,就完全可以在其值上使用 条件判断,然后写成 “$p(y|x, \theta)$” 来替代 “$p(y|x; \theta)$”。

若有一个新的测试样本 $x$,然后要求我们对这个新样本进行预测,我们可以使用 $\theta$ 上的后验分布(posterior distribution)来计算分类标签(class label)上的后验分布:

$$

p(y|x,S)=\int_\theta p(y|x,\theta)p(\theta|S)d\theta\qquad (2)

$$

在上面这个等式中,$p(\theta|S)$ 来自等式 (1)。例如,如果目标是要根据给定的 $x$ 来预测对应的 $y$ 的值,那就可以输出$^4$:

4 如果 $y$ 是一个离散值(discrete-valued),那么此处的积分(integral)就用求和(summation)来替代。

$$

E[y|x,S]=\int_y y p(y|x,S)dy

$$

这里我们简单概述的这个过程,可认为是一种“完全贝叶斯 (fully Bayesian)”预测,其中我们的预测是通过计算相对于 $\theta$ 上的后验概率 $p(\theta|S)$ 的平均值而得出的。然而很不幸,这 个后验分布的计算通常是比较困难的。这是因为如等式 (1) 所示,这个计算需要对 $\theta$ 进行积分(integral),而 $\theta$ 通常是高维度的(high-dimensional),这通常是不能以闭合形式 (closed-form)来实现的。

因此在实际应用中,我们都是用一个与 $\theta$ 的后验分布 (posterior distribution)近似的分布来替代。常用的一个近似是把对 $\theta$ 的后验分布(正如等式$(2)$中所示)替换为一个单点估计(single point estimate)。对 $\theta$ 的最大后验估计 (MAP,maximum a posteriori estimate)为:

$$

\theta_{MAP}=\arg \max_\theta \prod_{i=1}^{m} p(y^{(i)}|x^{(i)})p(\theta)

$$

注意到了么,这个式子基本和对 $\theta$ 的最大似然估计(ML (maximum likelihood) estimate)是一样的方程,除了末尾多了 一个先验概率分布 $p(\theta)$。

实际应用里面,对先验概率分布 $p(\theta)$ 的常见选择是假设 $\theta\sim N(0 , \tau ^2I)$。使用这样的一个先验概率分布,拟合出来的参数 $\theta_{MAP}$ 将比最大似然得到的参数有更小的范数(norm)。 (更多细节参考习题集 #3。)在实践中,贝叶斯最大后验估计(Bayesian MAP estimate)比参数的最大似然估计 (ML estimate of the parameters)更易于避免过拟合。例如,贝叶斯逻辑回归(Bayesian logistic regression)就是一种非常有效率的文本分类(text classification)算法,即使文本分类中参数规模 $n$ 通常是远远大于样本规模 $m$ 的,即 $n\gg m$。

第六章

1 感知器(perceptron)和大型边界分类器(large margin classifiers)

本章是讲义中关于学习理论的最后一部分,我们来介绍另外机器学习模式。在之前的内容中,我们考虑的都是批量学习的情况,即给了我们训练样本集合用于学习,然后用学习得到的假设 $h$ 来评估和判别测试数据。在本章,我们要讲一种新的机器学习模式:在线学习,这种情况下,我们的学习算法要在进行学习的同时给出预测。

学习算法会获得一个样本序列,其中内容为有次序的学习样本,$(x^{(1)},y^{(1)}), (x^{(2)},y^{(2)}), …(x^{(m)},y^{(m)})$。最开始获得的就是$x^{(1)}$,然后需要预测$y^{(1)}$。在完成了这个预测之后,再把$y^{(1)}$的真实值告诉给算法(然后算法就利用这个信息来进行某种学习了)。接下来给算法提供$x^{(2)}$,再让算法对$y^{(2)}$进行预测,然后再把$y^{(2)}$ 的真实值告诉给算法,这样算法就又能学习到一些信息了。这样的过程一直持续到最末尾的样本$(x^{(m)},y^{(m)})$。在这种在线学习的背景下,我们关心的是算法在此过程中出错的总次数。因此,这适合需要一边学习一边给出预测的应用情景。

接下来,我们将对感知器学习算法(perceptron algorithm)的在线学习误差给出一个约束。为了让后续的推导(subsequent derivations)更容易,我们就用正负号来表征分类标签,即设 $y =\in {-1, 1}$。

回忆一下感知器算法(在第二章中有讲到),其参数 $\theta \in R^{n+1}$,该算法据下面的方程来给出预测:

$$

h_\theta(x)=g(\theta^T x)\qquad (1)

$$

其中:

$$

g(z)= \begin{cases} 1 & if\quad z\ge 0 \

-1 & if\quad z<0 \end{cases}

$$

然后,给定一个训练样本 $(x, y)$,感知器学习规则(perceptron learning rule)就按照如下所示来进行更新。如果 $h_\theta(x) = y$,那么不改变参数。若二者相等关系不成立,则进行更新$^1$:

$$

\theta :=\theta+yx

$$

1 这和之前我们看到的更新规则(update rule)的写法稍微有一点点不一样,因为这里我们把分类标签(labels)改成了 $y \in {-1, 1}$。另外学习速率参数(learning rate parameter) $\alpha$ 也被省去了。这个速率参数的效果只是使用某些固定的常数来对参数 $\theta$ 进行缩放,并不会影响生成器的行为效果。

当感知器算法作为在线学习算法运行的时候,每次对样本给出错误判断的时候,则更新参数,下面的定理给出了这种情况下的在线学习误差的约束边界。要注意,下面的错误次数的约束边界与整个序列中样本的个数 $m$ 不具有特定的依赖关系(explicit dependence),和输入特征的维度 $n$ 也无关。

定理 (Block, 1962, and Novikoff, 1962)。 设有一个样本序列:$(x^{(1)},y^{(1)}), (x^{(2)},y^{(2)}), …(x^{(m)},y^{(m)})$。假设对于所有的 $i$ ,都有 $||x^{(i)}|| \le D$,更进一步存在一个单位长度向量 $u (||u||_2 = 1)$ 对序列中的所有样本都满足 $y(i) \cdot (u^T x^{(i)}) \ge \gamma$(例如,如果$y^{(i)} = 1$,则$u^T x^{(i)} \ge \gamma$, 而如果 $y^{(i)} = -1$,则 $u^T x^{(i)} \le -\gamma$,以便 $u$ 就以一个宽度至少为 $\gamma$ 的边界分开了样本数据)。而此感知器算法针对这个序列给出错误预测的总数的上限为 $(D/\gamma)^2$ 。

证明: 感知器算法每次只针对出错的样本进行权重更新。设 $\theta(k)$ 为犯了第 $k$ 个错误(k-th mistake)的时候的权重。则 $\theta^{(1)} = -\theta$(因为初始权重为零),若第 $k$ 个错误发生在样本 $(x^{(i)},y^{(i)})$,则$g((x(i))^T \theta^{(k)}) \ne y^{(i)}$,也就意味着:

$$

(x^{(i)})^T\theta^{(k)}y^{(i)}\le 0\qquad(2)

$$

另外根据感知器算法的定义,我们知道 $\theta^{(k+1)} = \theta^{(k)} + y^{(i)}x^{(i)}$

然后就得到:

$$

\begin{aligned}

(\theta^{(k+1)})^T u &= (\theta^{(k)})^T u + y^{(i)}(x^{(i)})^T u\

&\ge (\theta^{(k)})^T u + \gamma

\end{aligned}

$$

利用一个简单的归纳法(straightforward inductive argument)得到:

$$

(\theta^{(k+1)})^T u \ge k\gamma\qquad (3)

$$

还是根据感知器算法的定义能得到:

$$

\begin{aligned}

||\theta^{(k+1)}||^2 &= ||\theta^{(k)} + y^{(i)}x^{(i)}||^2 \

&= ||\theta^{(k)}||^2 + ||x^{(i)}||^2 + 2y^{(i)}(x^{(i)})^T\theta^{(k)} \

&\le ||\theta^{(k)}||^2 + ||x^{(i)}||^2 \

&\le ||\theta^{(k)}||^2 + D\qquad\qquad(4)

\end{aligned}

$$

上面这个推导过程中,第三步用到了等式(2)。另外这里还要使用一次简单归纳法,上面的不等式(4) 表明:

$$

||\theta^{(k+1)}||^2 \le KD^2

$$

把上面的等式 (3) 和不等式 (4) 结合起来:

$$

\begin{aligned}

\sqrt{k}D &\ge ||\theta^{(k+1)}|| \

&\ge (\theta^{(k+1)})^T u \

&\ge k\gamma

\end{aligned}

$$

上面第二个不等式是基于 $u$ 是一个单位长度向量($z^T u = ||z||\cdot ||u|| cos \phi\le ||z||\cdot ||u||$,其中的$\phi$是向量 $z$ 和向量 $u$ 的夹角)。结果则表明 $k\le (D/\gamma)^2$。因此,如果感知器犯了一个第 $k$ 个错误,则 $k\le (D/\gamma)^2$。

第七章a

k 均值聚类算法(k-means clustering algorithm)

在聚类的问题中,我们得到了一组训练样本集 ${x^{(1)},…,x^{(m)}}$,然后想要把这些样本划分成若干个相关的“类群(clusters)”。其中的 $x^{(i)}\in R^n$,而并未给出分类标签 $y^{(i)}$ 。所以这就是一个无监督学习的问题了。

$K$ 均值聚类算法如下所示:

- 随机初始化(initialize)聚类重心(cluster centroids) $\mu_1, \mu_2,…, \mu_k\in R^n$ 。

- 重复下列过程直到收敛(convergence): {

对每个 $i$,设

$$

c^{(i)}:=arg\min_j||x^{(i)}-\mu_j||^2

$$

对每个 $j$,设

$$

\mu_j:=\frac{\sum_{i=1}^m1{c^{(i)}=j}x^{(i)}}{\sum_{i=1}^m1{c^{(i)}=j}}

$$

}

在上面的算法中,$k$ 是我们这个算法的一个参数,也就是我们要分出来的群组个数(number of clusters);而聚类重心 $\mu_j$ 表示的是我们对各个聚类的中心位置的当前猜测。在上面算法的第一步当中,需要初始化(initialize)聚类重心(cluster centroids),可以这样实现:随机选择 $k$ 个训练样本,然后设置聚类重心等于这 $k$ 个样本 各自的值。(当然也还有其他的初始化方法。)

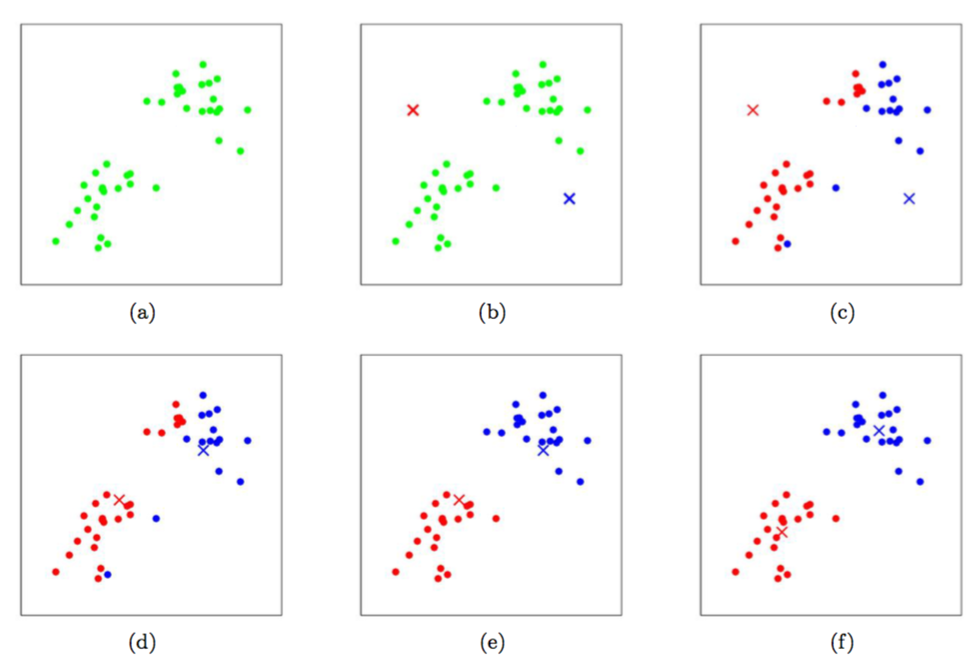

算法的第二步当中,循环体内重复执行两个步骤:(i)将每个训练样本$x^{(i)}$ “分配(assigning)”给距离最近的聚类重心$\mu_j$;(ii)把每个聚类重心$\mu_j$ 移动到所分配的样本点的均值位置。下面的 图1 就展示了运行 $k$均值聚类算法的过程。

图1:$k$ 均值聚类算法。图中的圆形点表示的是训练样本,交叉符号表示的是聚类重心。(a) 原始训练样本数据集。 (b) 随机初始化的聚类重心(这里的初始化方法就跟我们上面说的不一样,并没有从训练样本中选择两个点)。(c-f) 运行 $k$ 均值聚类算法中的两步迭代的示意图。在每一次迭代中,我们把每个训练样本分配给距其最近的聚类重心(用同样颜色标识出),然后把聚类重心移动到所分配的样本的均值位置。(用颜色区分效果最好了。)图片引用自 Michael Jordan。

$K$ 均值聚类算法能保证收敛性么?可以的,至少在一定意义上能这么说。尤其是我们可以定义一个下面这样的函数作为失真函数(distortion function):

$$

J(c,\mu)=\sum_{i=1}^m ||x^{(i)}-\mu_{c^{(i)}}||^2

$$

这样就可以用 $J$ 来衡量每个样本 $x^{(i)}$ 和对应的聚类重心$\mu_{c^{(i)}}$之间距离的平方和。很明显能看出 $k$ 均值聚类算法正好就是对 $J$ 的坐标下降过程。尤其是内部的循环体中,$k$ 均值聚类算法重复对 $J$ 进行最小化,当 $\mu$ 固定的时候用 $c$ 来最小化 $J$,当 $c$ 固定的时候则用 $\mu$ 最小化 $J$。这样就保证了 $J$ 是单调降低的(monotonically decrease),它的值也就必然收敛(converge)。(通常这也表明了 $c$ 和 $\mu$ 也收敛。在理论上来讲,$k$均值 可能会在几种不同的聚类之间摆动(oscillate),也就是说某些组不同值的 $c$ 和/或 $\mu$ 对应有完全相同的 $J$ 值,不过在实践中这种情况几乎不会遇到。)

失真函数 $J$,是一个非凸函数(non-convex function),所以对 $J$ 进行坐标下降(coordinate descent)并不一定能够收敛到全局最小值(global minimum)。也就是说,$k$ 均值聚类算法可能只是局部最优的(local optima)。通常除了这个问题之外,$k$ 均值聚类效果都不错,能给出很好的聚类。如果你担心陷入到某些比较差的局部最小值,通常可以多次运行 $k$ 均值距离(使用不同的随机值进行来对聚类重心 $\mu_j$ 进行初始化)。然后从所有的不同聚类方案(clusterings)中,选择能提供最小失真(distortion) $J(c,\mu)$ 的。

第七章b

混合高斯 (Mixtures of Gaussians) 和期望最大化算法(the EM algorithm)

在本章讲义中,我们要讲的是使用期望最大化算法(EM,Expectation-Maximization)来进行密度估计(density estimation)。

一如既往,还是假设我们得到了某一个训练样本集${x^{(1)},…,x^{(m)}}$。由于这次是非监督学习(unsupervised learning)环境,所以这些样本就没有什么分类标签了。

我们希望能够获得一个联合分布 $p(x^{(i)},z^{(i)}) = p(x^{(i)}|z^{(i)})p(z^{(i)})$ 来对数据进行建模。其中的 $z^{(i)} \sim Multinomial(\phi)$ (即$z^{(i)}$ 是一个以 $\phi$ 为参数的多项式分布,其中 $\phi_j \ge 0, \sum_{j=1}^k \phi_j=1$,而参数 $\phi_j$ 给出了 $p(z^{(i)} = j)$),另外 $x^{(i)}|z^{(i)} = j \sim N(μ_j,\Sigma_j)$ (译者注:$x^{(i)}|z^{(i)} = j$是一个以 $μ_j$ 和 $\Sigma_j$ 为参数的正态分布)。我们设 $k$ 来表示 $z^{(i)}$ 能取的值的个数。因此,我们这个模型就是在假设每个$x^{(i)}$ 都是从${1, …, k}$中随机选取$z^{(i)}$来生成的,然后 $x^{(i)}$ 就是服从$k$个高斯分布中的一个,而这$k$个高斯分布又取决于$z^{(i)}$。这就叫做一个混合高斯模型(mixture of Gaussians model)。 此外还要注意的就是这里的 $z^{(i)}$ 是潜在的随机变量(latent random variables),这就意味着其取值可能还是隐藏的或者未被观测到的。这就会增加这个估计问题(estimation problem)的难度。

我们这个模型的参数也就是 $\phi, \mu$ 和 $\Sigma$。要对这些值进行估计,我们可以写出数据的似然函数(likelihood):

$$

\begin{aligned}

l(\phi,\mu,\Sigma) &= \sum_{i=1}^m \log p(x^{(i)};\phi,\mu,\Sigma) \

&= \sum_{i=1}^m \log \sum_{z^{(i)}=1}^k p(x^{(i)}|z^{(i)};\mu,\Sigma)p(z^{(i)};\phi)

\end{aligned}

$$

然而,如果我们用设上面方程的导数为零来尝试解各个参数,就会发现根本不可能以闭合形式(closed form)来找到这些参数的最大似然估计(maximum likelihood estimates)。(不信的话你自己试试咯。)

随机变量 $z^{(i)}$表示着 $x^{(i)}$ 所属于的 $k$ 个高斯分布值。这里要注意,如果我们已知 $z^{(i)}$,这个最大似然估计问题就简单很多了。那么就可以把似然函数写成下面这种形式:

$$

l(\phi,\mu,\Sigma)=\sum_{i=1}^m \log p(x^{(i)}|z^{(i)};\mu,\Sigma) + \log p(z^{(i)};\phi)

$$

对上面的函数进行最大化,就能得到对应的参数$\phi, \mu$ 和 $\Sigma$:

$$

\begin{aligned}

&\phi_j=\frac 1m\sum_{i=1}^m 1{z^{(i)}=j}, \

&\mu_j=\frac{\sum_{i=1}^m 1{z^{(i)}=j}x^{(i)}}{\sum_{i=1}^m 1{z^{(i)}=j}}, \

&\Sigma_j=\frac{\sum_{i=1}^m 1{z^{(i)}=j}(x^{(i)}-\mu_j)(x^{(i)}-\mu_j)^T}{\sum_{i=1}^m 1{z^{(i)}=j}}.

\end{aligned}

$$

事实上,我们已经看到了,如果 $z^{(i)}$ 是已知的,那么这个最大似然估计就几乎等同于之前用高斯判别分析模型(Gaussian discriminant analysis model)中对参数进行的估计,唯一不同在于这里的 $z^{(i)}$ 扮演了高斯判别分析当中的分类标签$^1$的角色。

1 这里的式子和之前在 PS1 中高斯判别分析的方程还有一些小的区别,这首先是因为在此处我们把 $z^{(i)}$ 泛化为多项式分布(multinomial),而不是伯努利分布(Bernoulli),其次是由于这里针对高斯分布中的每一项使用了一个不同的 $\Sigma_j$。

然而,在密度估计问题里面,$z^{(i)}$ 是不知道的。这要怎么办呢?

期望最大化算法(EM,Expectation-Maximization)是一个迭代算法,有两个主要的步骤。针对我们这个问题,在 $E$ 这一步中,程序是试图去“猜测(guess)” $z^{(i)}$ 的值。然后在 $M$ 这一步,就根据上一步的猜测来对模型参数进行更新。由于在 $M$ 这一步当中我们假设(pretend)了上一步是对的,那么最大化的过程就简单了。下面是这个算法:

重复下列过程直到收敛(convergence): {

($E$-步骤)对每个 $i, j$, 设

$$

w_j^{(i)} := p(z^{(i)}=j|x^{(i)};\phi,\mu,\Sigma)

$$

($M$-步骤)更新参数:

$$

\begin{aligned}

&\phi_j=\frac 1m\sum_{i=1}^m w_j^{(i)}, \

&\mu_j=\frac{\sum_{i=1}^m w_j^{(i)}x^{(i)}}{\sum_{i=1}^m w_j^{(i)}}, \

&\Sigma_j=\frac{\sum_{i=1}^m w_j^{(i)}(x^{(i)}-\mu_j)(x^{(i)}-\mu_j)^T}{\sum_{i=1}^m w_j^{(i)}}.

\end{aligned}

$$

}

在 $E$ 步骤中,在给定 $x^{(i)}$ 以及使用当前参数设置(current setting of our parameters)情况下,我们计算出了参数 $z^{(i)}$ 的后验概率(posterior probability)。使用贝叶斯规则(Bayes rule),就得到下面的式子:

$$

p(z^{(i)}=j|x^{(i)};\phi,\mu,\Sigma)=

\frac{p(x^{(i)}|z^{(i)}=j;\mu,\Sigma)p(z^{(i)}=j;\phi)}

{\sum_{l=1}^k p(x^{(i)}|z^{(i)}=l;\mu,\Sigma)p(z^{(i)}=l;\phi)}

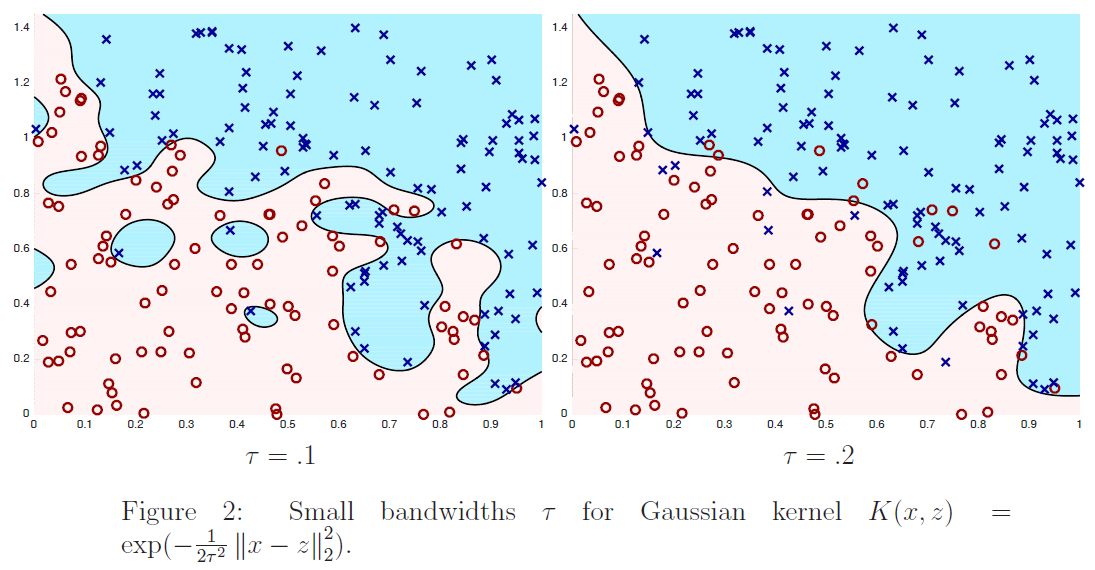

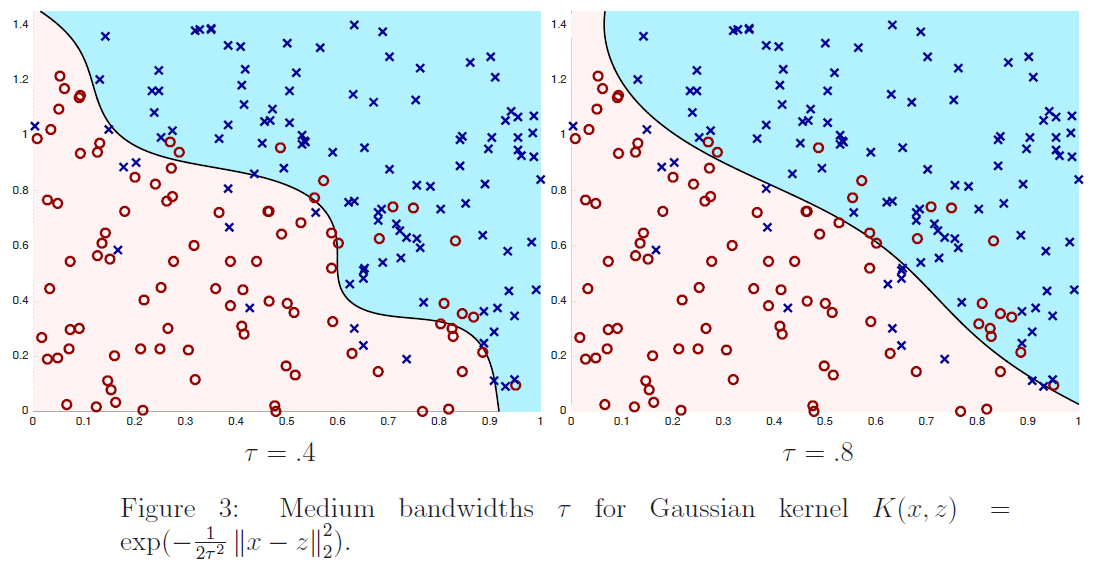

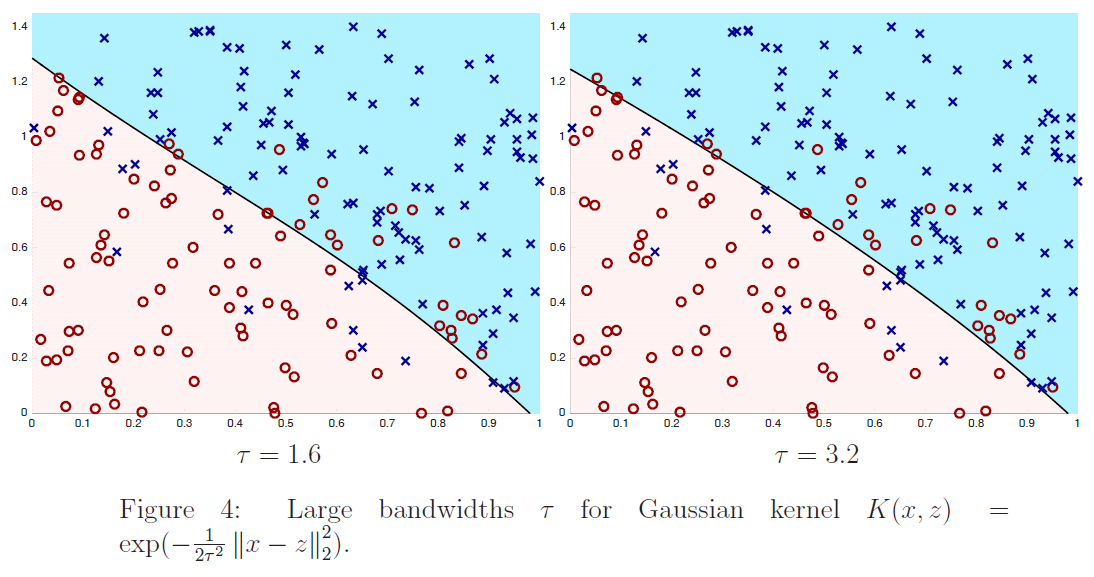

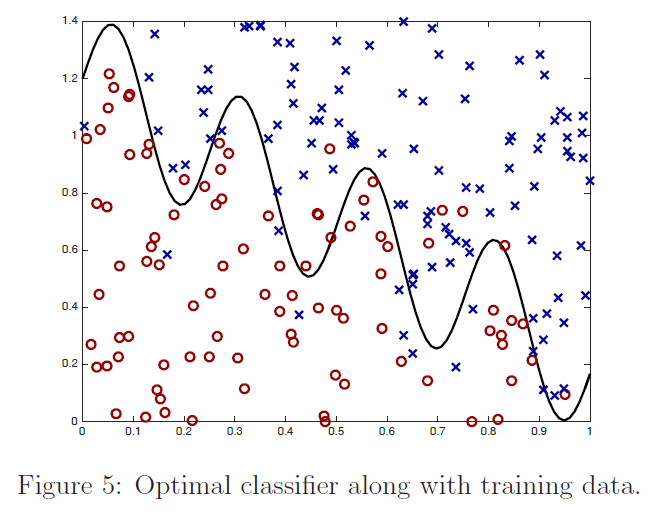

$$